FAQ

March 16, 2021

Pendahuluan

Algoritma menyediakan pelatihan untuk membantu para pekerja profesional maupun pelajar untuk mencapai keterampilan dasar dalam berbagi bidang data science yang terdiri dari: Data Visualization, Machine Learning, Data Modelling, Inferensial Statistik, dll. Kumpulan FAQ ini diproduksi oleh tim Algoritma untuk membantu para peserta Data Science Academy atau khalayak umum mengenai pertanyaan pertanyaan yang sering ditemukan mengenai topik machine learning.

Bab 1 Data Wrangling

1.1 Regular Expression

1.1.1 Bagaimana cara membuat nama kolom menjadi lebih rapih saat dilakukan visualisasi?

#> [1] "trending_date" "title" "channel_title"

#> [4] "category_id" "publish_time" "views"

#> [7] "likes" "dislikes" "comment_count"

#> [10] "comments_disabled" "ratings_disabled" "video_error_or_removed"Untuk membuat tampilan visualisasi menjadi lebih rapih kita dapat mengubah nama kolom menggunakan function str_replace() dan str_to_title(). Function str_replace() akan mengubah nama kolom dengan menghapus pattern "_". Sedangkan function str_to_title() akan membuat huruf awal setiap kata menjadi uppercase.

#> [1] "Trending Date" "Title" "Channel Title"

#> [4] "Category Id" "Publish Time" "Views"

#> [7] "Likes" "Dislikes" "Comment Count"

#> [10] "Comments Disabled" "Ratings Disabled" "Video Error_or_removed"1.1.2 Bagaimana cara mengubah nama kolom dengan bentuk (pattern) tertentu?

Pada data laporan kita memiliki kolom “hasil_pajak_daerah”, “hasil_retribusi_daerah”, “hasil_pengelolaan_kekayaan_daerah_yang_dipisahkan”. Berikut ini kita akan mengubah nama kolom yang memiliki pattern hasil_ diubah menjadi total_ menggunakan function str_replace()

daerah <chr> | provinsi <chr> | jenis <chr> | |

|---|---|---|---|

| Kab Aceh Barat | Aceh | Anggaran | |

| Kab Aceh Besar | Aceh | Anggaran | |

| Kab Aceh Selatan | Aceh | Anggaran | |

| Kab Aceh Singkil | Aceh | Anggaran | |

| Kab Aceh Tengah | Aceh | Anggaran | |

| Kab Aceh Tenggara | Aceh | Anggaran | |

| Kab Aceh Timur | Aceh | Anggaran | |

| Kab Aceh Utara | Aceh | Anggaran | |

| Kab Bireun | Aceh | Anggaran | |

| Kab Pidie | Aceh | Anggaran |

#> [1] "daerah"

#> [2] "provinsi"

#> [3] "jenis"

#> [4] "periode"

#> [5] "pendapatan_daerah"

#> [6] "pendapatan_asli_daerah"

#> [7] "total_pajak_daerah"

#> [8] "total_retribusi_daerah"

#> [9] "total_pengelolaan_kekayaan_daerah_yang_dipisahkan"

#> [10] "lain_lain_pendapatan_asli_daerah_yang_sah"

#> [11] "dana_perimbangan"

#> [12] "dana_bagi_total_pajak_bagi_hasil_bukan_pajak"

#> [13] "dana_alokasi_umum"

#> [14] "dana_alokasi_khusus"

#> [15] "lain_lain_pendapatan_daerah_yang_sah"

#> [16] "pendapatan_hibah"

#> [17] "dana_darurat"

#> [18] "dana_bagi_total_pajak_dari_provinsi_dan_pemerintah_daerah_lainnya"

#> [19] "dana_penyesuaian_dan_otonomi_khusus"

#> [20] "bantuan_keuangan_dari_provinsi_atau_pemerintah_daerah_lainnya"

#> [21] "pendapatan_lain_lain"

#> [22] "belanja_daerah"

#> [23] "belanja_pegawai_l"

#> [24] "belanja_barang_dan_jasa"

#> [25] "belanja_modal"1.1.3 Bagaimana cara menggabungkan dua atau lebih vector ke dalam satu vector?

Kita dapat menggunakan function str_c() sebagai berikut:

#> [1] "Music,Gaming,Shows"Function str_c() juga dapat digunakan untuk membuat vector dengan pattern yang berulang sebagai berikut:

#> [1] "Laporan-2017-Q1" "Laporan-2018-Q1" "Laporan-2019-Q1" "Laporan-2020-Q1"1.1.4 Apa perbedaan dari function str_replace() dan str_replace_all()?

Ketika menggunakan function str_replace() akan mengubah pattern pertama yang ditemui, sebagai berikut:

#> [1] "d-ta" "sc-ence" "-lgoritma"Sedangkan function str_replace_all() akan mengubah semua pattern yang ditemui pada vector, sebagai berikut:

#> [1] "d-t-" "sc--nc-" "-lg-r-tm-"1.2 Working Datetime

1.2.1 Bagaimana cara mengubah variabel/kolom bertipe “character” menjadi “date”, jika dalam 1 kolom terdapat format (urutan) tanggal yang berbeda?

Untuk mengubah tipe data “character” menjadi “date” pada kolom yang memiliki format (urutan) tanggal yang berbeda-beda, dapat mnggunakan fungsi parse_date() dari library parsedate.

# membuat sebuah vector yang berisi tanggal dengan format yang berbeda

tanggal <- c("1-January-2020", "01/01/20", "12-31-2019")

tanggal <- parsedate::parse_date(tanggal)

class(tanggal)#> [1] "POSIXct" "POSIXt"#> [1] "2020-01-01 UTC" "2020-01-01 UTC" "2019-12-31 UTC"1.3 Data Transformation with dplyr

1.3.1 Bagaimana cara melakukan subsetting baris (filter) terhadap baris-baris yang sama dengan beberapa nilai? Misal, akan dilakukan filter terhadap baris-baris yang memiliki ketegori (category_id) Comedy, Music, atau Gaming?

Untuk melakukan filter terhadap baris-baris yang sama dengan beberapa nilai (lebih dari satu nilai), dapat menggunakan operator atau | ataupun menggunakan operator inlude %in%.

#> [1] People and Blogs Entertainment Comedy

#> [4] Science and Technology Film and Animation News and Politics

#> [7] Sports Music Pets and Animals

#> [10] Education Howto and Style Autos and Vehicles

#> [13] Travel and Events Gaming Nonprofit and Activism

#> [16] Shows

#> 16 Levels: Autos and Vehicles Comedy Education ... Travel and Eventsfilter1 <- vids %>%

filter(category_id == "Comedy" | category_id == "Music" | category_id == "Gaming")

unique(filter1$category_id)#> [1] Comedy Music Gaming

#> 16 Levels: Autos and Vehicles Comedy Education ... Travel and Events# code di atas dapat disederhanakan menjadi

filter1 <- vids %>%

filter(category_id %in% c("Gaming", "Music", "Comedy"))

unique(filter1$category_id)#> [1] Comedy Music Gaming

#> 16 Levels: Autos and Vehicles Comedy Education ... Travel and EventsBerikut contoh kasus jika baris-baris yang ingin dipilih tidak sama dengan beberapa nilai (lebih dari satu nilai), dapat menggunakan operator dan & ataupun menggunakan operator include %in% yang digabungkan dengan operator tidak !.

filter2 <- vids %>%

filter(category_id != "Comedy" & category_id != "Music" & category_id != "Gaming")

unique(filter2$category_id)#> [1] People and Blogs Entertainment Science and Technology

#> [4] Film and Animation News and Politics Sports

#> [7] Pets and Animals Education Howto and Style

#> [10] Autos and Vehicles Travel and Events Nonprofit and Activism

#> [13] Shows

#> 16 Levels: Autos and Vehicles Comedy Education ... Travel and Events# code di atas dapat disederhanakan menjadi

filter2 <- vids %>%

filter(!category_id %in% c("Comedy", "Music", "Gaming"))

unique(filter2$category_id)#> [1] People and Blogs Entertainment Science and Technology

#> [4] Film and Animation News and Politics Sports

#> [7] Pets and Animals Education Howto and Style

#> [10] Autos and Vehicles Travel and Events Nonprofit and Activism

#> [13] Shows

#> 16 Levels: Autos and Vehicles Comedy Education ... Travel and Events1.3.2 Bagaimana cara menampilkan kolom yang memiliki unsur kata dana?

Untuk menampilkan kolom dengan kata (term) tertentu dapat menggunakan function select_at() dari package dplyr:

#> dana_perimbangan dana_bagi_hasil_pajak_bagi_hasil_bukan_pajak

#> 1 782044000000 21953000000

#> 2 977082000000 22236000000

#> 3 983548000000 17732000000

#> 4 598216000000 18482000000

#> 5 841794000000 16607000000

#> 6 799735000000 14301000000

#> dana_alokasi_umum dana_alokasi_khusus dana_darurat

#> 1 570764000000 189327000000 0

#> 2 713345000000 241502000000 0

#> 3 641605000000 324211000000 0

#> 4 441266000000 138468000000 0

#> 5 603737000000 221449000000 0

#> 6 586091000000 199342000000 0

#> dana_bagi_hasil_pajak_dari_provinsi_dan_pemerintah_daerah_lainnya

#> 1 24441000000

#> 2 29527000000

#> 3 30141000000

#> 4 20609000000

#> 5 29389000000

#> 6 42186000000

#> dana_penyesuaian_dan_otonomi_khusus

#> 1 256083000000

#> 2 412171000000

#> 3 216237000000

#> 4 90964000000

#> 5 232677000000

#> 6 2522390000001.3.3 Bagaimana cara menampilkan kolom dengan lebih dari satu kata (term) tertentu?

Berikut ini kita akan menampilkan kolom yang memiliki unsur Pendapatan atau Daerah dengan bantuan function matches() dari package dplyr

#> daerah pendapatan_daerah pendapatan_asli_daerah hasil_pajak_daerah

#> 1 Kab Aceh Barat 1251178000000 164141000000 16170000000

#> 2 Kab Aceh Besar 1662846000000 132396000000 60500000000

#> 3 Kab Aceh Selatan 1396406000000 165862000000 10570000000

#> 4 Kab Aceh Singkil 785724000000 55233000000 10645000000

#> 5 Kab Aceh Tengah 1286924000000 183064000000 11374000000

#> 6 Kab Aceh Tenggara 1168068000000 73908000000 11715000000

#> hasil_retribusi_daerah hasil_pengelolaan_kekayaan_daerah_yang_dipisahkan

#> 1 9410000000 4916000000

#> 2 5910000000 3500000000

#> 3 9346000000 5200000000

#> 4 25836000000 3378000000

#> 5 12565000000 5300000000

#> 6 2115000000 3000000000

#> lain_lain_pendapatan_asli_daerah_yang_sah

#> 1 133644000000

#> 2 62487000000

#> 3 140746000000

#> 4 15374000000

#> 5 153826000000

#> 6 57078000000

#> lain_lain_pendapatan_daerah_yang_sah pendapatan_hibah

#> 1 304994000000 24470000000

#> 2 553368000000 31670000000

#> 3 246995000000 618000000

#> 4 132275000000 20702000000

#> 5 262065000000 0

#> 6 294425000000 0

#> dana_bagi_hasil_pajak_dari_provinsi_dan_pemerintah_daerah_lainnya

#> 1 24441000000

#> 2 29527000000

#> 3 30141000000

#> 4 20609000000

#> 5 29389000000

#> 6 42186000000

#> bantuan_keuangan_dari_provinsi_atau_pemerintah_daerah_lainnya

#> 1 0

#> 2 80000000000

#> 3 0

#> 4 0

#> 5 0

#> 6 0

#> pendapatan_lain_lain belanja_daerah

#> 1 0 1278780000000

#> 2 0 1757856000000

#> 3 0 1410406000000

#> 4 0 794579000000

#> 5 0 1287177000000

#> 6 0 12576540000001.3.4 Bagaimana cara menampilkan kolom dengan kata (term) awalan atau akhiran tertentu?

Untuk meampilkan kolom yang diawali dengan kata Dana atau diakhiri dengan kata pajak dapat menggunakan bantuan function starts_with() dan ends_with() dari package dplyr

#> dana_perimbangan dana_bagi_hasil_pajak_bagi_hasil_bukan_pajak

#> 1 782044000000 21953000000

#> 2 977082000000 22236000000

#> 3 983548000000 17732000000

#> 4 598216000000 18482000000

#> 5 841794000000 16607000000

#> 6 799735000000 14301000000

#> dana_alokasi_umum dana_alokasi_khusus dana_darurat

#> 1 570764000000 189327000000 0

#> 2 713345000000 241502000000 0

#> 3 641605000000 324211000000 0

#> 4 441266000000 138468000000 0

#> 5 603737000000 221449000000 0

#> 6 586091000000 199342000000 0

#> dana_bagi_hasil_pajak_dari_provinsi_dan_pemerintah_daerah_lainnya

#> 1 24441000000

#> 2 29527000000

#> 3 30141000000

#> 4 20609000000

#> 5 29389000000

#> 6 42186000000

#> dana_penyesuaian_dan_otonomi_khusus

#> 1 256083000000

#> 2 412171000000

#> 3 216237000000

#> 4 90964000000

#> 5 232677000000

#> 6 252239000000#> dana_bagi_hasil_pajak_bagi_hasil_bukan_pajak

#> 1 21953000000

#> 2 22236000000

#> 3 17732000000

#> 4 18482000000

#> 5 16607000000

#> 6 143010000001.3.5 Bagaimana cara menampilkan data teratas untuk setiap kategori dari variabel tertentu?

Berikut ini kita akan menampilkan jenis Anggaran terbaru untuk setiap provinsi, langkah yang dilakukan sebagai berikut:

- Melakukan filter pada kolom jenis untuk tipe "Anggaran"

- Mengurutkan periode dari yang terbaru hingga terlama

- Melakukan grouping berdasarkan `provinsi`

- Menampilkan 1 data teratas untuk setiap provinsiOutput berikut ini menampilkan Anggaran terbaru dari setiap provinsi:

laporan %>%

filter(

jenis == "Anggaran"

) %>%

arrange(daerah, desc(periode)) %>%

group_by(provinsi) %>%

slice(1)#> # A tibble: 34 x 25

#> # Groups: provinsi [34]

#> daerah provinsi jenis periode pendapatan_daer~ pendapatan_asli~

#> <chr> <chr> <chr> <chr> <dbl> <dbl>

#> 1 Kab A~ Aceh Angg~ 2018-0~ 1251178000000 164141000000

#> 2 Kab B~ Bali Angg~ 2018-0~ 6567484000000 5700511000000

#> 3 Kab B~ Bangka ~ Angg~ 2018-0~ 1045407000000 140835000000

#> 4 Kab L~ Banten Angg~ 2018-0~ 2414034000000 299733000000

#> 5 Kab B~ Bengkulu Angg~ 2018-0~ 900262000000 58720000000

#> 6 Kab B~ DI Yogy~ Angg~ 2018-0~ 2056183000000 420143000000

#> 7 Prov ~ DKI Jak~ Angg~ 2018-0~ 66029983000000 44570508000000

#> 8 Kab B~ Goronta~ Angg~ 2018-0~ 828164000000 46238000000

#> 9 Kab B~ Jambi Angg~ 2018-0~ 1246198000000 112000000000

#> 10 Kab B~ Jawa Ba~ Angg~ 2018-0~ 5064214000000 813568000000

#> # ... with 24 more rows, and 19 more variables: hasil_pajak_daerah <dbl>,

#> # hasil_retribusi_daerah <dbl>,

#> # hasil_pengelolaan_kekayaan_daerah_yang_dipisahkan <dbl>,

#> # lain_lain_pendapatan_asli_daerah_yang_sah <dbl>, dana_perimbangan <dbl>,

#> # dana_bagi_hasil_pajak_bagi_hasil_bukan_pajak <dbl>,

#> # dana_alokasi_umum <dbl>, dana_alokasi_khusus <dbl>,

#> # lain_lain_pendapatan_daerah_yang_sah <dbl>, pendapatan_hibah <dbl>,

#> # dana_darurat <dbl>,

#> # dana_bagi_hasil_pajak_dari_provinsi_dan_pemerintah_daerah_lainnya <dbl>,

#> # dana_penyesuaian_dan_otonomi_khusus <dbl>,

#> # bantuan_keuangan_dari_provinsi_atau_pemerintah_daerah_lainnya <dbl>,

#> # pendapatan_lain_lain <dbl>, belanja_daerah <dbl>, belanja_pegawai_l <dbl>,

#> # belanja_barang_dan_jasa <dbl>, belanja_modal <dbl>1.3.6 Bagaimana cara untuk memisahkan beberapa nilai pada 1 baris/observasi di kolom tertentu ke dalam beberapa kolom?

Berikut ini kita memiliki variabel product yang berisikan berbagai macam product yang dibeli oleh customer, bagaimana cara kita untuk memisahkan variabel tersebut menjadi beberapa kolom untuk setiap product yang dibeli?

#> id product

#> 1 1 Milk, Cereal

#> 2 2 Coffe, Sugar, Milk

#> 3 3 Bread

#> 4 4 Tea, Sugar, BreadKita dapat menggunakan function separate() dari package tidyr sebagai berikut:

#> id Product-1 Product-2 Product-3

#> 1 1 Milk Cereal <NA>

#> 2 2 Coffe Sugar Milk

#> 3 3 Bread <NA> <NA>

#> 4 4 Tea Sugar Bread1.3.7 Apa perbedaan dari left_join, right_join, full_join, dan inner_join?

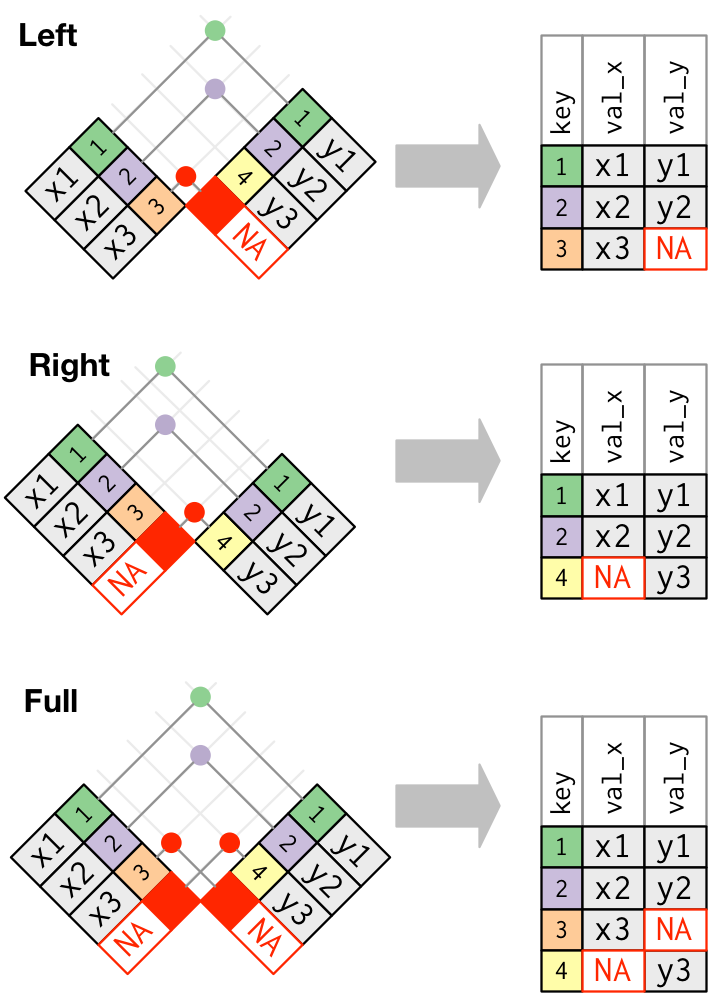

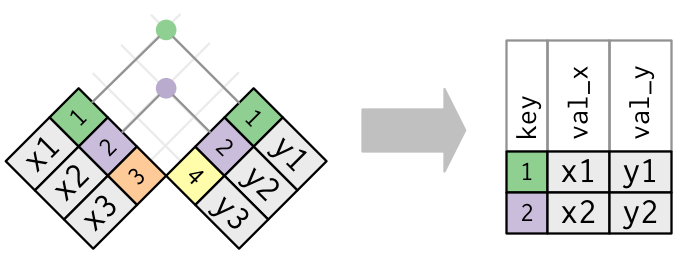

- Function

left_join()akan mempertahankan observasi X - Function

right_join()akan mempertahankan observasi Y - Function

full_join()akan menampilkan observasi yang berada pada data X atau Y - Function

inner_join()akan menampilkan observasi yang terdapat pada data X dan Y.

1.3.8 Bagaimana cara menghilangkan bahasa latin pada data?

Untuk menghilangkan bahasa latin pada data dapat menggunakan fungsi stri_trans_general() dari library stringi

#> [1] "Special, satisfação, Happy, Sad, Potential, für"#> [1] "Special, satisfacao, Happy, Sad, Potential, fur"1.4 Handling Missing Value

1.4.1 Bagaimana cara mengatasi missing value pada data?

Salah satu cara menangani missing value adalah melakukan imputation atau mengisi missing value dengan suatu nilai. Package tidyr menyediakan function fill() yang berfungsi untuk mengisi missing value menggunakan nilai observasi berikutnya atau sebelumnya.

#> # A tibble: 4 x 3

#> person treatment response

#> <chr> <dbl> <dbl>

#> 1 Derrick Whitmore 1 7

#> 2 <NA> 2 10

#> 3 <NA> 3 9

#> 4 Katherine Burke 1 4Function fill() memiliki parameter direction untuk mengatur arah nilai yang akan diisi. Parameter direction terdiri dari “down”, “up”, “downup”, dan “updown”.

#> # A tibble: 4 x 3

#> person treatment response

#> <chr> <dbl> <dbl>

#> 1 Derrick Whitmore 1 7

#> 2 Derrick Whitmore 2 10

#> 3 Derrick Whitmore 3 9

#> 4 Katherine Burke 1 4Tentunya penanganan tersebut tidak dapat diterapkan untuk semua data, penanganan ini dapat digunakan untuk format data yang memiliki nilai tidak berulang.

1.5 DB Connections

Bagaimana mengkoneksikan database ke R?

1.5.1 MySQL

# 1. Library

library(RMySQL)

# 2. Settings

db_user <- 'mydatabase_admin'

db_password <- 'bintang123#'

db_name <- 'iris'

db_table <- 'irisData'

db_host <- '127.0.0.1' # for local access

db_port <- 3306

mydb <- dbConnect(MySQL(),

user = db_user,

password = db_password,

dbname = db_name,

host = db_host,

port = db_port)

# 3. Read data from db

# SELECT * FROM irisData LIMIT 5

s <- paste0("select * from ", db_table, " limit 5")

rs <- dbSendQuery(mydb, s)

df <- fetch(rs)

on.exit(dbDisconnect(mydb))1.5.2 SQL Server

Connecting to SQL Server from R

# 1. Library

library(DBI)

library(odbc)

# list driver

sort(unique(odbcListDrivers()[[1]]))

# 2. Settings

conn <- dbConnect(odbc(),

Driver = "SQL Server", # check your odbcinst.ini

Server = "localhost\\SQLEXPRESS", # server ip address

Port = 3306,

UID = "mydatabase_admin", # username

PWD = "bintang123#", # password

Database = "iris") # database name1.5.3 SQLite

- database

# 1. Library

library(RSQLite)

library(DBI)

# 2. Settings

conn <- dbConnect(SQLite(),

host = '127.0.0.1', # for local host

port = 3306,

user = 'mydatabase_admin',

password = 'bintang123#',

db = 'iris')- local file

Bab 2 Data Visualization & Interactive Plotting

2.1 Data Visualization

2.1.1 Base Plot

2.1.2 Geom

2.1.2.1 Bagaimana cara menambahkan separator (,) untuk memisahkan angka ribuan pada label geom_text()/geom_label() yang terletak pada setiap batang (bar) di bar plot?

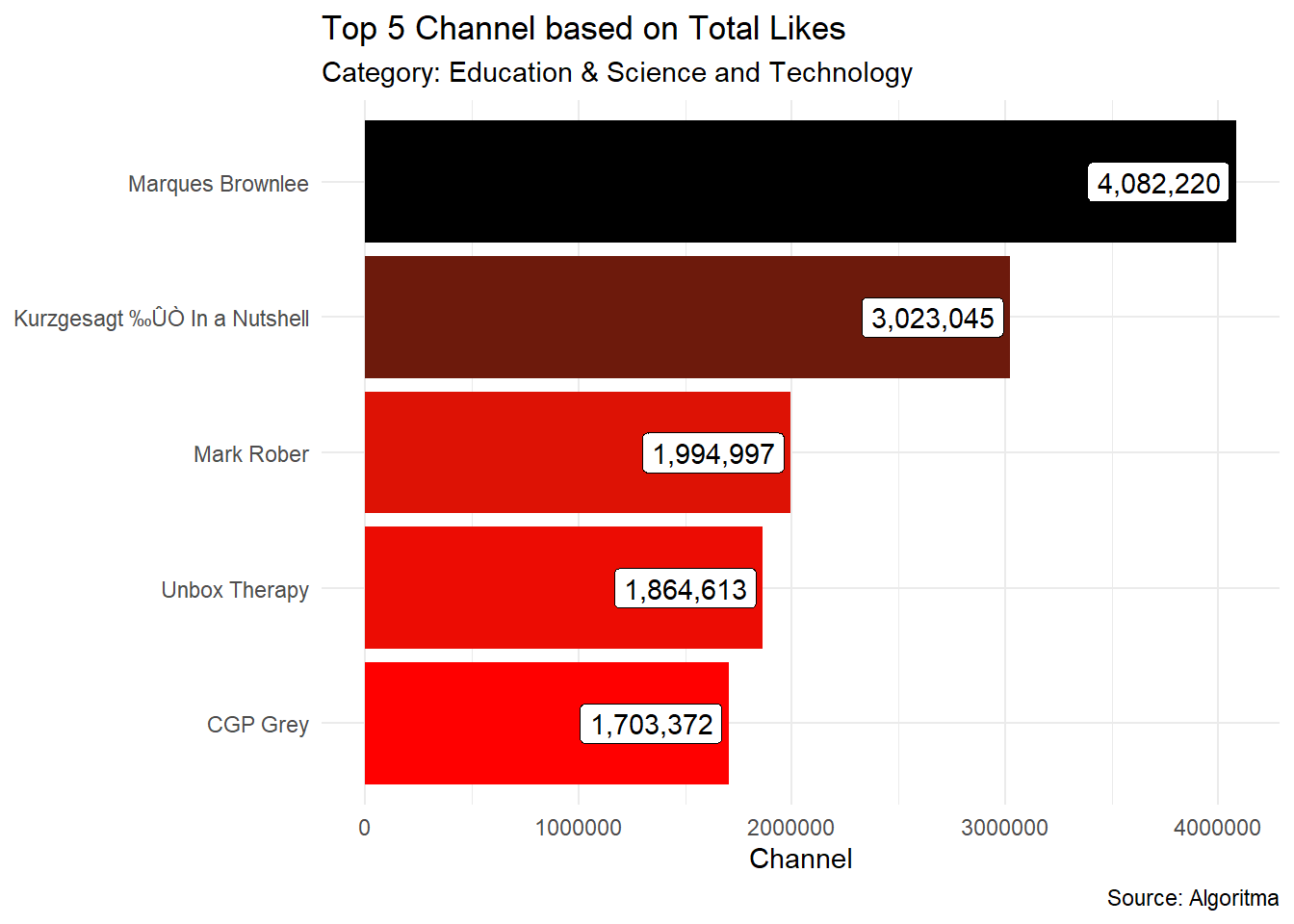

Untuk menambahkan separator (,) dengan tujuan memisahkan angka ribuan pada label geom_text()/geom_label() yang terletak pada setiap batang di bar plot, bisa menggunakan fungsi comma() dari package scales.

vids1 <- vids %>%

filter(category_id %in% c("Education", "Science and Technology")) %>%

group_by(channel_title, category_id) %>%

summarise(total.likes = sum(likes)) %>%

ungroup() %>%

arrange(desc(total.likes)) %>%

head(5)ggplot(vids1, aes(x = total.likes,y = reorder(channel_title, total.likes))) +

geom_col(aes(fill = total.likes), show.legend = F) +

labs(title = "Top 5 Channel based on Total Likes",

subtitle = "Category: Education & Science and Technology",

x = "Channel",

y = NULL,

caption = "Source: Algoritma") +

geom_label(aes(label = comma(total.likes)), hjust = 1.05) +

scale_fill_gradient(low = "red", high = "black") +

theme_minimal()

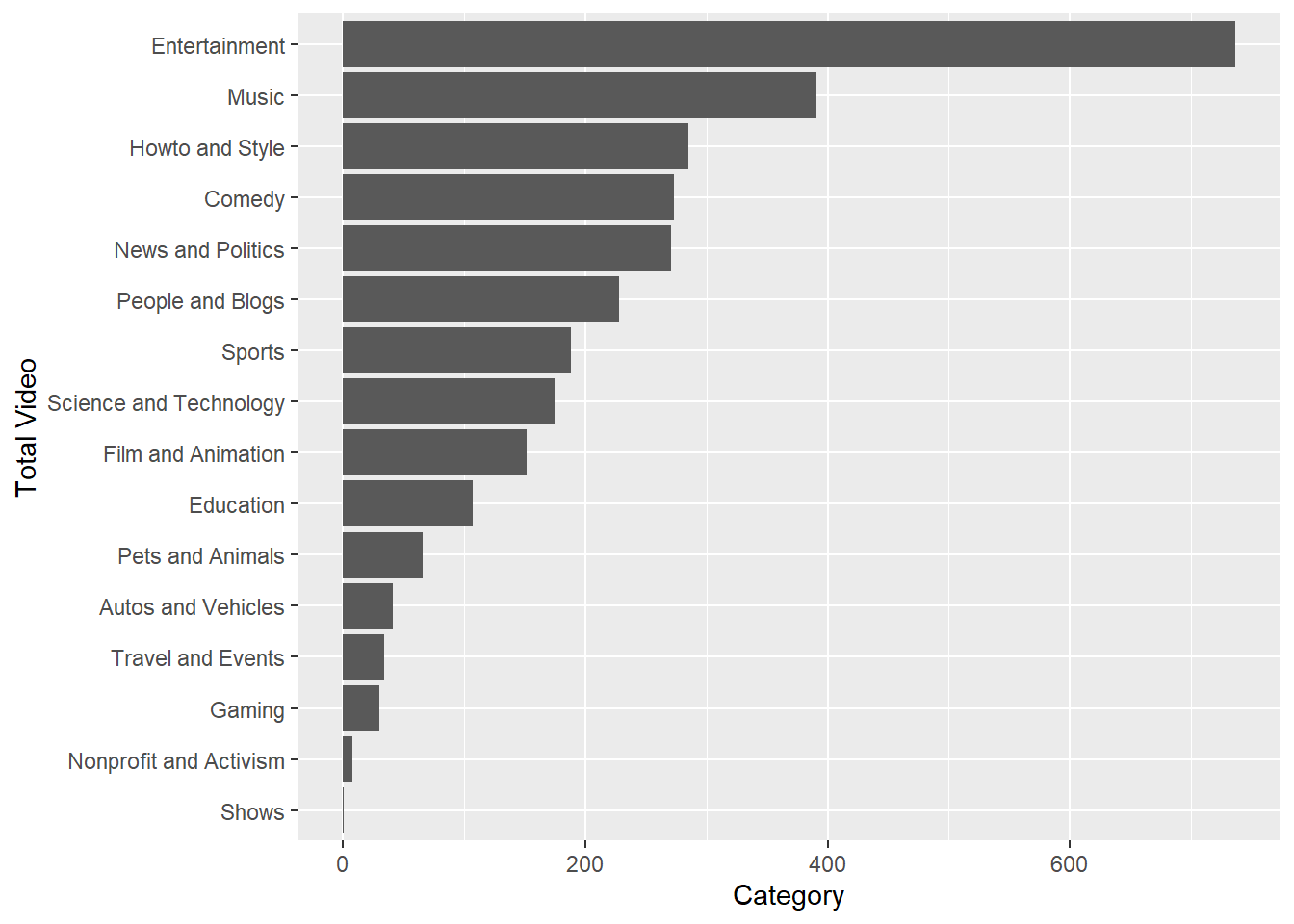

2.1.2.2 Bagaimana cara untuk mengurutkan batang (bar) saat menggunakan geom_bar()?

Untuk mengurutkan batang ketika menggunakan geom_bar kita dapat menggunakan function fct_infreq() dari package forcats, kemudian untuk mengatur bar dari paling besar hingga paling kecil kita dapat menggunakan bantuan function fct_rev().

ggplot(data = vids.u, mapping = aes(y = fct_rev(fct_infreq(category_id))))+

geom_bar() +

labs( x = "Category",

y = "Total Video")

2.1.2.3 Bagaimana cara mengubah urutan kategori pada legend?

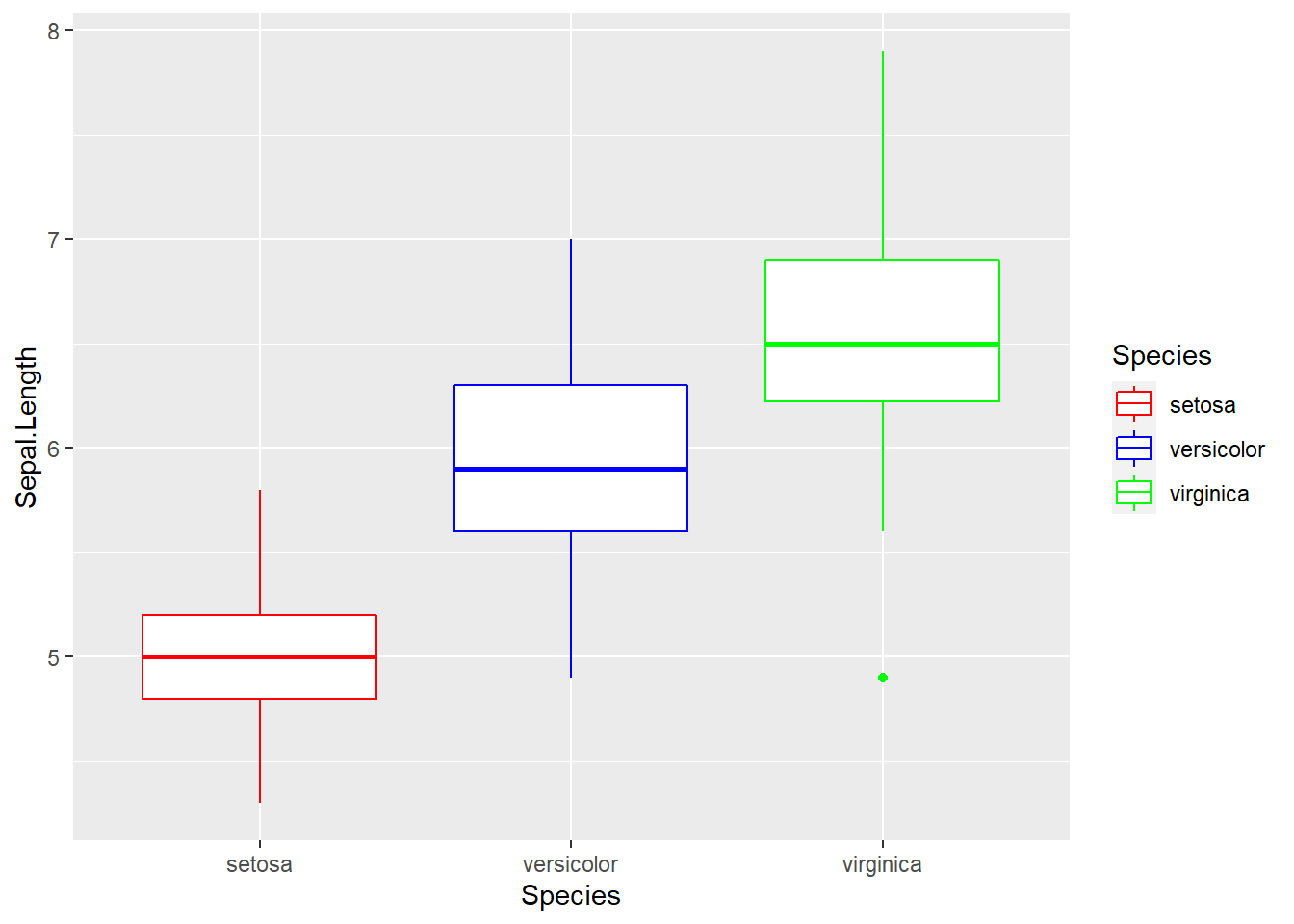

ggplot(data = iris, aes(x = Species,y = Sepal.Length))+

geom_boxplot(aes(color = Species))+

scale_color_manual(values = c("red","blue","green"))

Secara default kategori pada legend akan diurutkan berdasarkan urutan level/kategori:

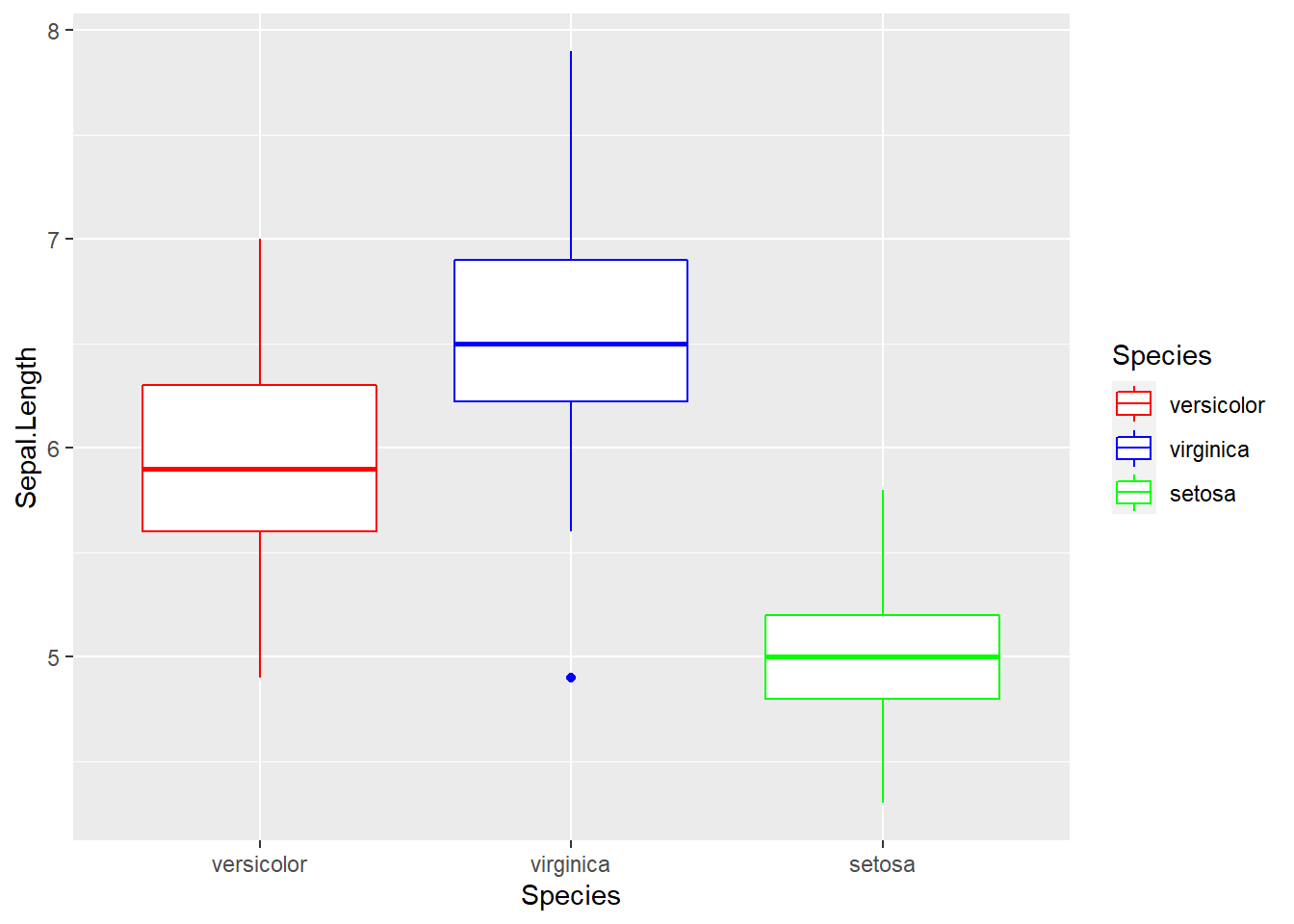

#> [1] "setosa" "versicolor" "virginica"Untuk mengurutkan kategori pada legend, kita dapat mengubah urutan level pada kolom kategori tersebut:

#order level

iris <- iris %>%

mutate(Species = factor(Species, levels = c("versicolor",

"virginica",

"setosa")))

#membuat visualisasi

ggplot(data = iris, aes(x = Species,y = Sepal.Length))+

geom_boxplot(aes(color = Species))+

scale_color_manual(values = c("red","blue","green"))

2.1.2.4 Bagaimana cara membuat lebih dari satu line pada satu grafik dengan menggunakan geom_line?

#> market_A market_B date

#> 1 100.00000 150.0000 2002-01-01

#> 2 92.31064 146.1417 2002-02-01

#> 3 82.61754 142.7523 2002-03-01

#> 4 84.71044 136.7259 2002-04-01

#> 5 66.96577 131.4398 2002-05-01

#> 6 65.70774 126.9375 2002-06-01Untuk membuat grafik line dari dua variabel sekaligus, kita perlu melakukan manipulasi dari kedua variabel tersebut menjadi satu variabel dengan bantuan function pivot_longer() dari package tidyr. Data yang akan diperoleh sebagai berikut:

data_viz <- datline %>%

pivot_longer(cols = c(market_A,market_B),

names_to = "market")

head(data_viz)#> # A tibble: 6 x 3

#> date market value

#> <date> <chr> <dbl>

#> 1 2002-01-01 market_A 100

#> 2 2002-01-01 market_B 150

#> 3 2002-02-01 market_A 92.3

#> 4 2002-02-01 market_B 146.

#> 5 2002-03-01 market_A 82.6

#> 6 2002-03-01 market_B 143.Setelah data dimanipulasi, selanjutnya kita dapat melakukan visualisasi seperti biasa. Karena kita ingin membedakan grafik line berdasarkan kategori, kita bisa menggunakan parameter group untuk membedakan grafik line berdasarkan category.

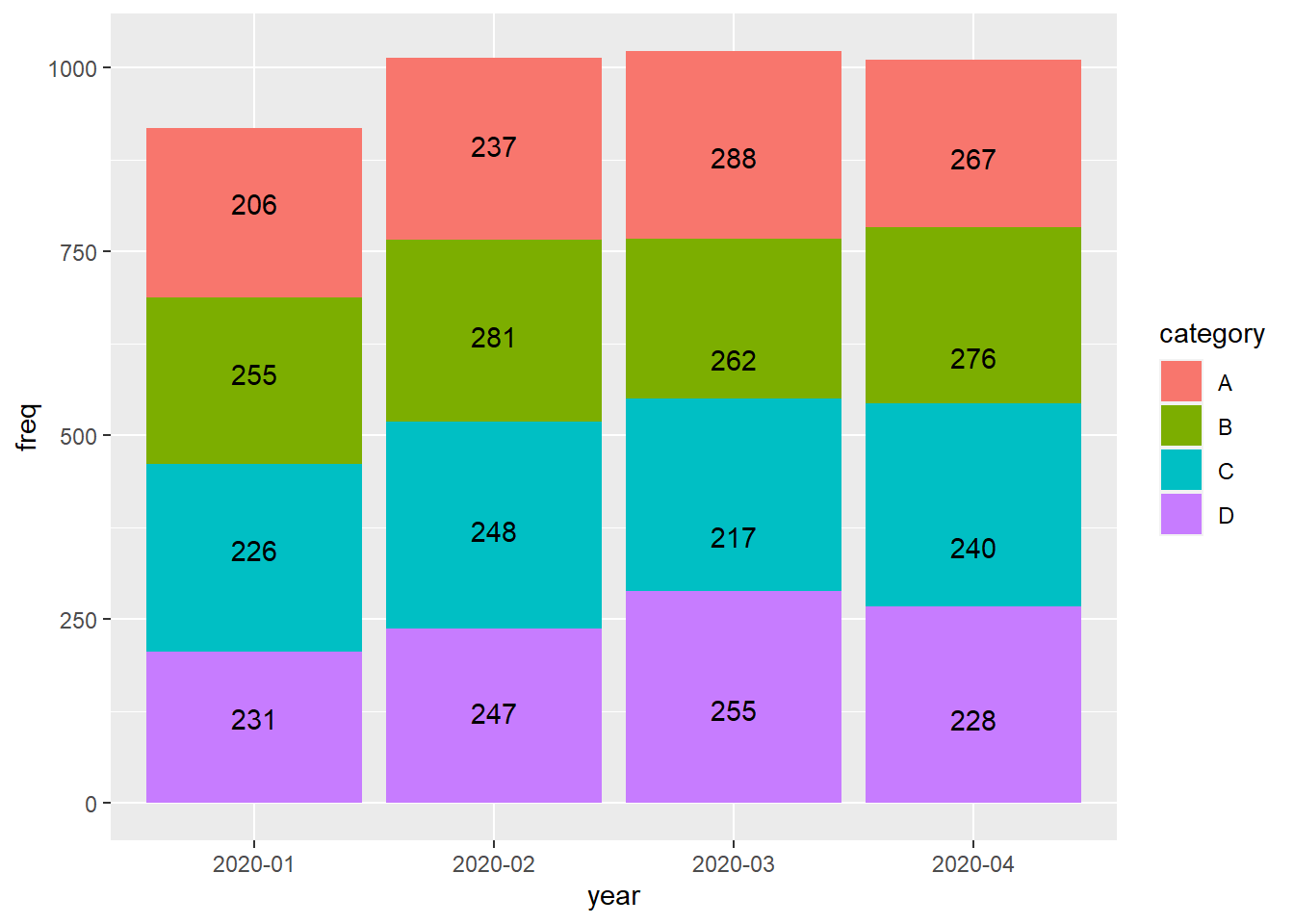

2.1.2.5 Bagaimana cara untuk menampilkan nilai (value) pada stacked bar?

Berikut ini merupakan data yang akan digunakan untuk visualisasi:

#> year category freq

#> 1 2020-01 A 231

#> 2 2020-01 B 226

#> 3 2020-01 C 255

#> 4 2020-01 D 206

#> 5 2020-02 A 247

#> 6 2020-02 B 248

#> 7 2020-02 C 281

#> 8 2020-02 D 237

#> 9 2020-03 A 255

#> 10 2020-03 B 217

#> 11 2020-03 C 262

#> 12 2020-03 D 288

#> 13 2020-04 A 228

#> 14 2020-04 B 240

#> 15 2020-04 C 276

#> 16 2020-04 D 267Untuk menampilkan value pada stack bar, kita dapat menambahkan function position_stack() pada geom_text dan juga sertakan label yang akan ditampilkan pada plot:

ggplot(dat_cat, aes(x = year,y = freq)) +

geom_col(position = "stack",

aes(fill = category))+

geom_text(aes(label = freq),

position = position_stack(vjust = 0.5))

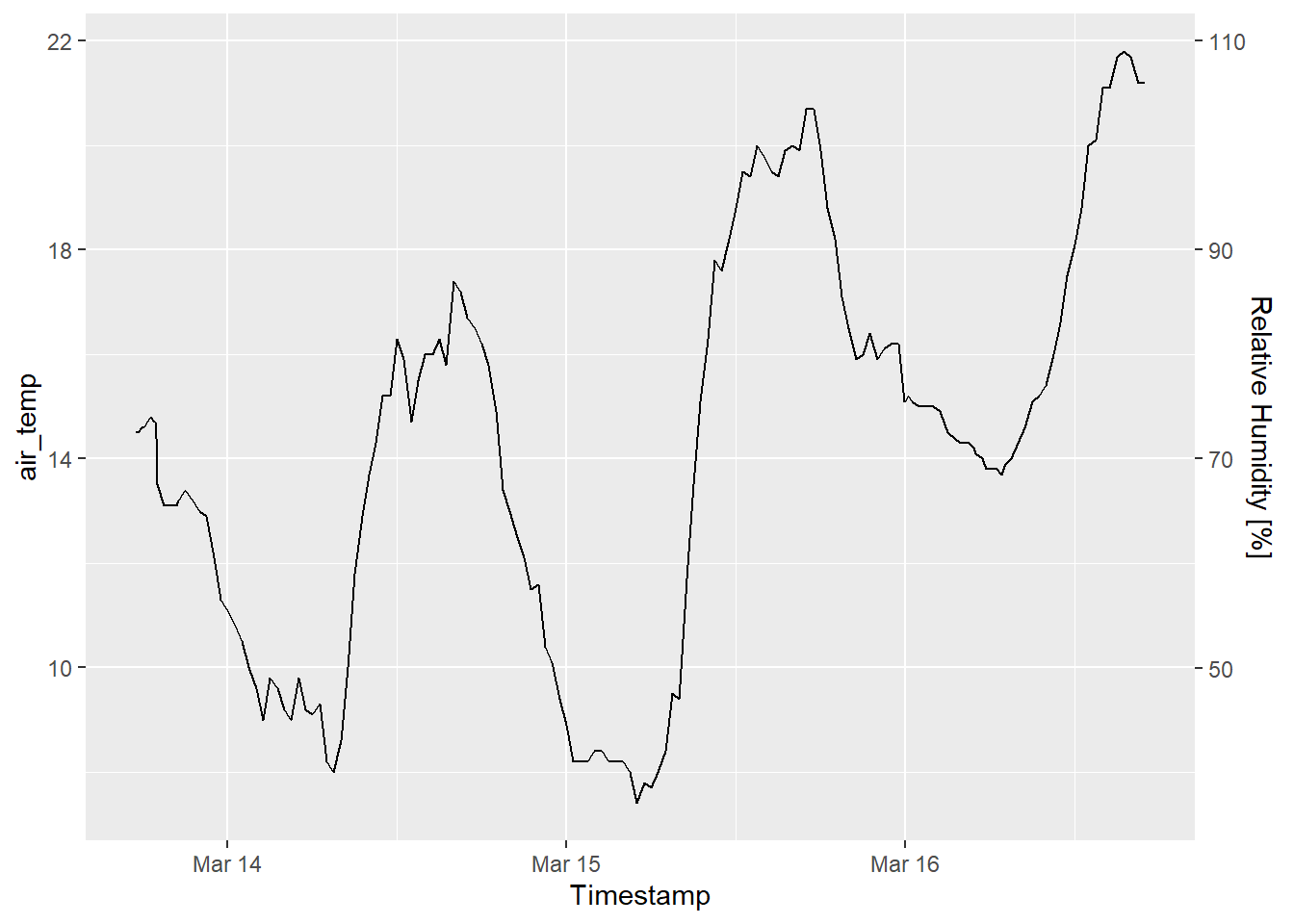

2.1.2.6 Bagaimana cara membuat secondary axis pada ggplot2?

#> Timestamp air_temp

#> 1 2021-03-16 17:00:00 21.2

#> 2 2021-03-16 16:30:00 21.2

#> 3 2021-03-16 16:00:00 21.7

#> 4 2021-03-16 15:30:00 21.8

#> 5 2021-03-16 15:00:00 21.7

#> 6 2021-03-16 14:30:00 21.1Penggunaan secondary axis pada ggplot2 diatur melalui function scale_y_continuous(), dengan menggunakan parameter sec.axis. Kita dapat menyesuaikan formula pada secondary axis tersebut pada parameter trans.

ggplot(data = weather, aes(x = Timestamp,y = air_temp))+

geom_line()+

scale_y_continuous(sec.axis = sec_axis(trans = ~.*5,

name = "Relative Humidity [%]"))

2.1.2.7 Bagaimana cara membuat multi row axis label pada ggplot?

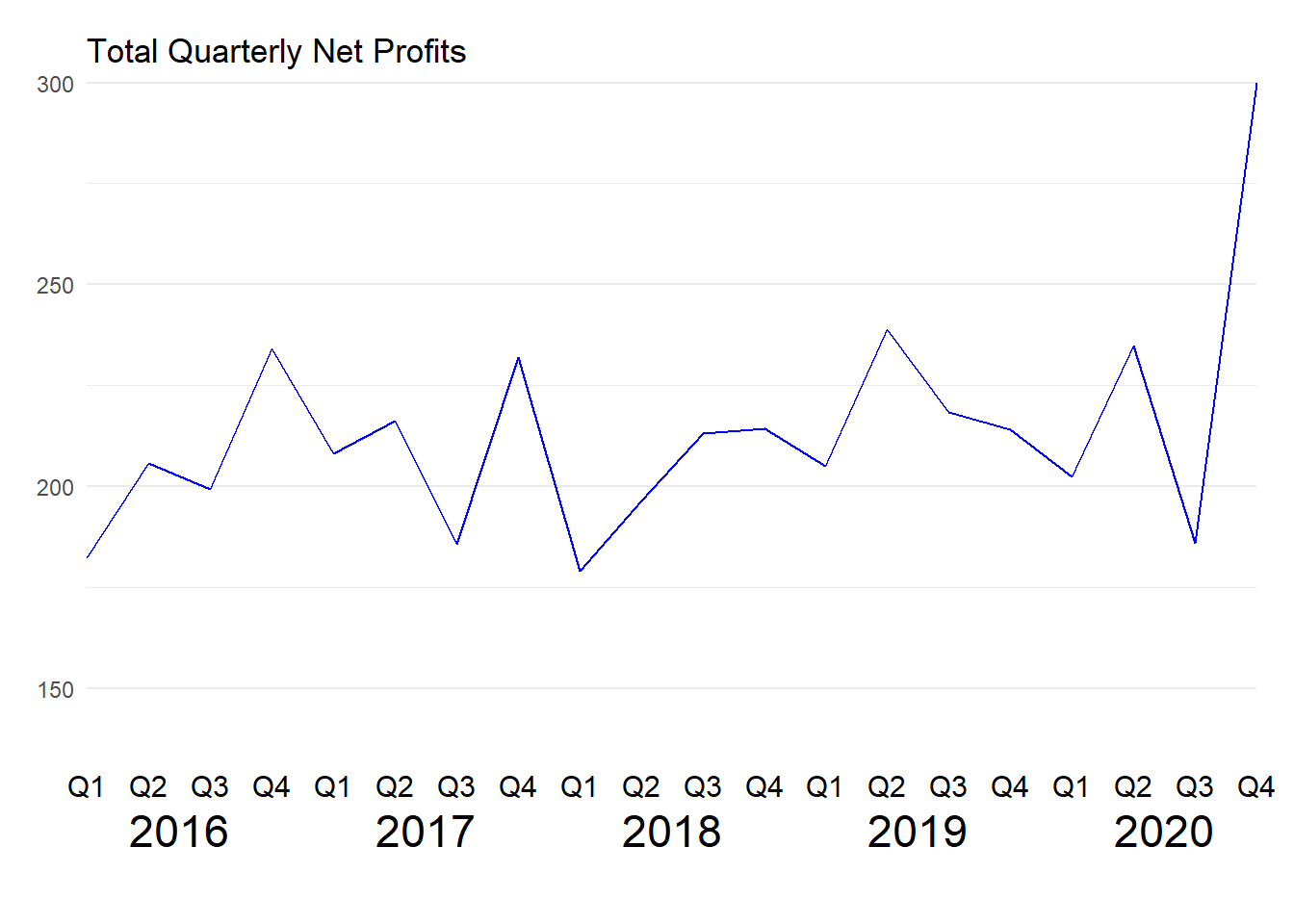

#> year quarter profit

#> 1 2016 Q1 182.4233

#> 2 2016 Q2 205.6036

#> 3 2016 Q3 199.2379

#> 4 2016 Q4 234.0375

#> 5 2017 Q1 208.0940

#> 6 2017 Q2 216.1521Untuk membuat multi axis pada ggplot, kita dapat menggunakan function annotate(). Pada function annotate() kita dapat menambahkah geom pada plot, namun tidak seperti geom lainnya yang memetakan data frame, melainkan untuk menyisipkan elemen vector seperti label text.

ggplot(data = dat_quarter, aes(x = interaction(year, quarter, lex.order = T),

y = profit, group = 1))+

geom_line(colour = "blue")+

annotate(geom = "text",

x = seq_len(nrow(dat_quarter)),

y = 126,

label = dat_quarter$quarter, size = 4)+

annotate(geom = "text",

x = 2.5 + 4 *(0:4),

y = 115,

label = unique(dat_quarter$year),

size = 6)+

coord_cartesian(ylim = c(130,300),

expand = FALSE,

clip = "off")+

labs(title = "Total Quarterly Net Profits",

y = NULL)+

theme_minimal() +

theme(plot.margin = unit(c(1, 1, 4, 1), "lines"),

axis.title.x = element_blank(),

axis.text.x = element_blank(),

panel.grid.major.x = element_blank(),

panel.grid.minor.x = element_blank())

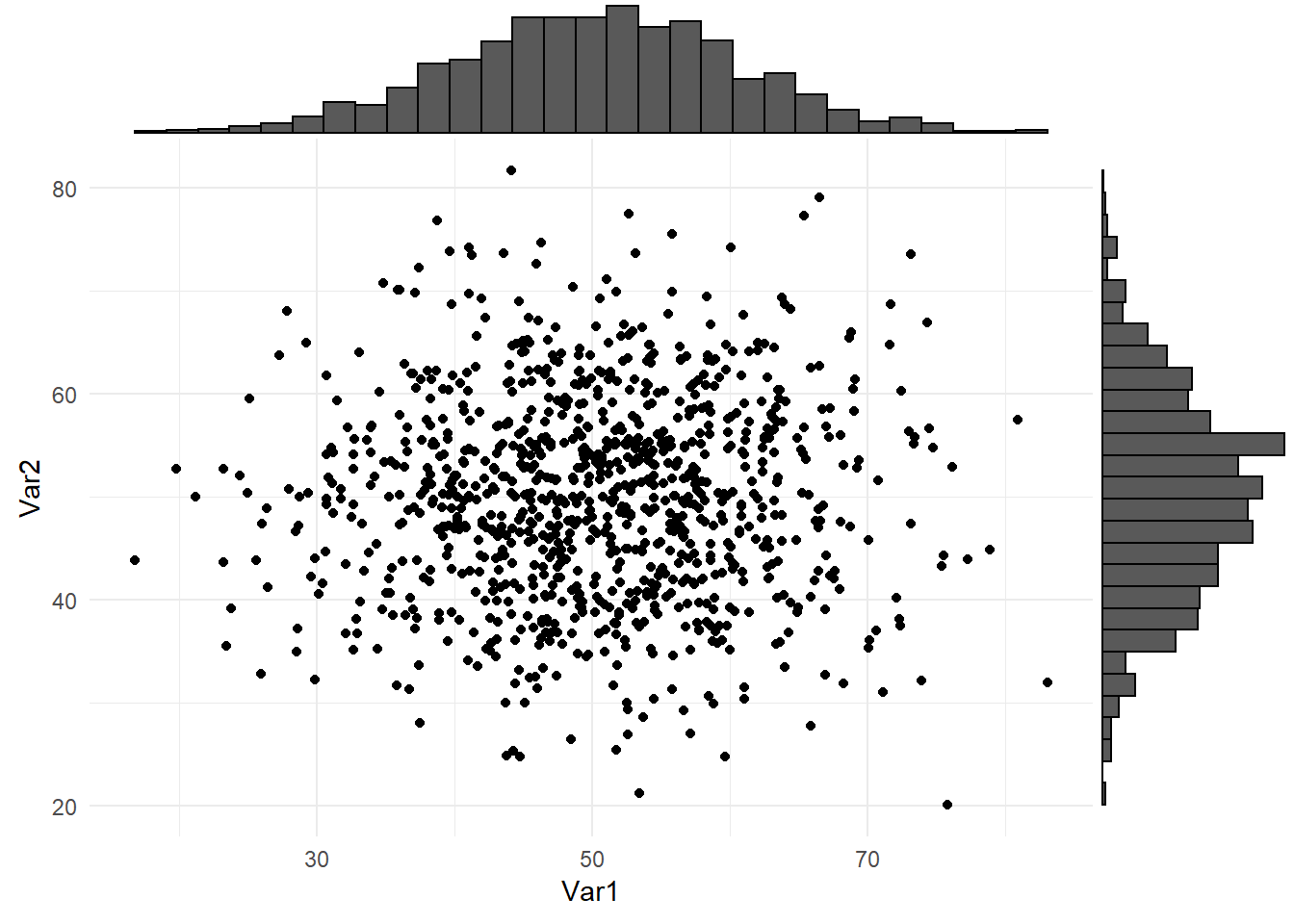

2.1.2.8 Bagaimana cara untuk membuat scatterplot dengan histogram marginal?

#> Var1 Var2

#> 1 44.97808 60.97650

#> 2 51.31531 61.81037

#> 3 49.21083 55.87511

#> 4 58.86785 60.76173

#> 5 51.16971 61.36653

#> 6 53.18630 57.60293Untuk membuat histogram marginal, kita dapat menggunakan function ggMarginal() dari package ggExtra. Kita dapat mengatur tipe grafik sesuai kebutuhan, tipe yang tersedia yaitu density, histogram, boxplot, violin, dan densigram.

p <- ggplot(data = df, aes(x = Var1,y = Var2))+

geom_point()+

theme_minimal()

ggExtra::ggMarginal(p, type = "histogram")

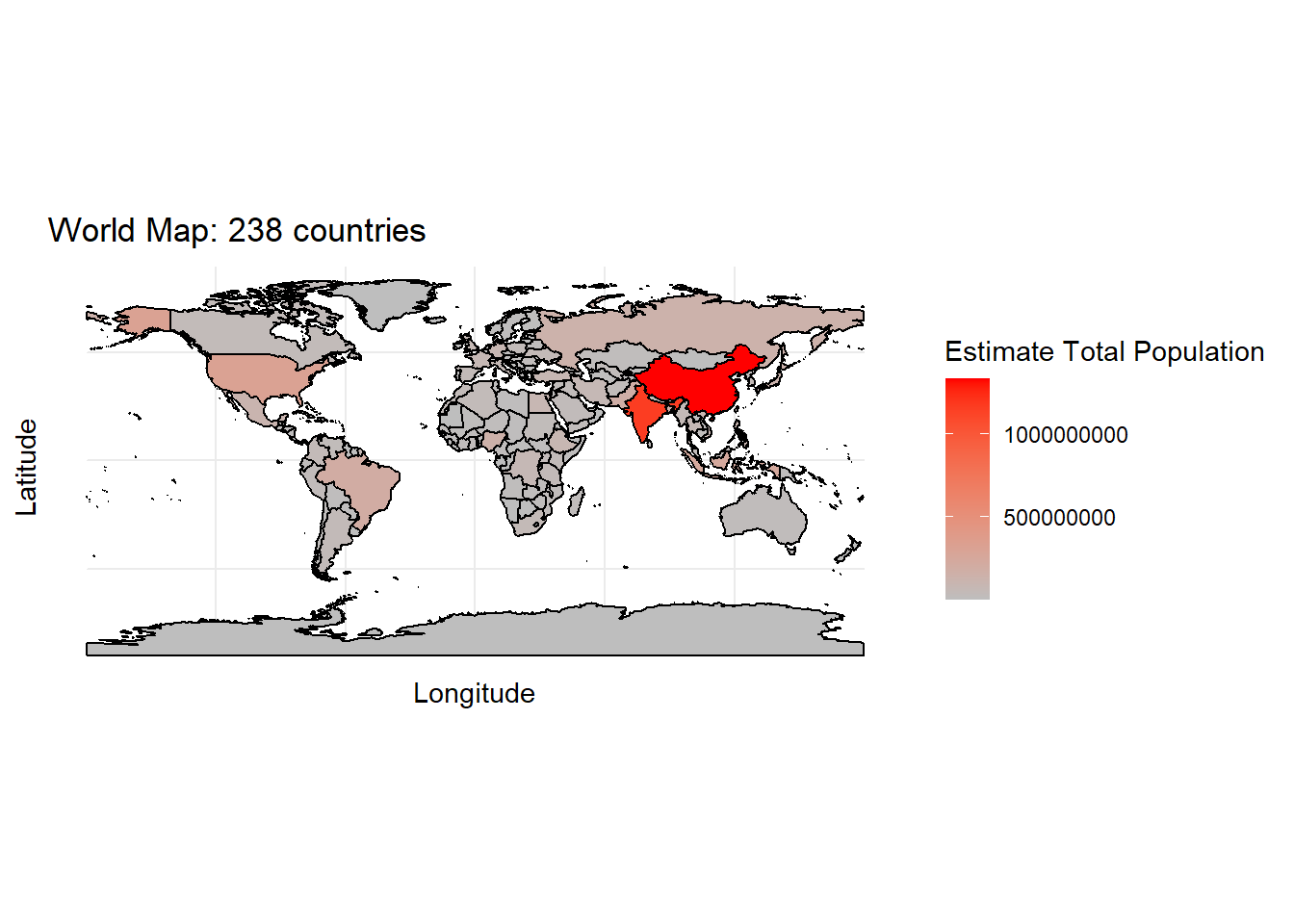

2.1.2.9 Bagaimana cara membuat spatial map menggunakan ggplot2?

Untuk membuat spatial map dengan ggplot2 kita bisa menggunakan geom_sf() sebagai berikut:

Data yang digunakan merupakan data default dari salah satu package R, yaitu rnaturalearth. Untuk menarik data tersebut dapat mengunakan fungsi ne_countries().

library(ggplot2)

library(sf)

library(rnaturalearth)

world_data <- ne_countries(scale = "medium", returnclass = "sf")

class(world_data)#> [1] "sf" "data.frame"Spatial map yang akan dibuat menggambarkan total poplasi penduduk untuk setiap negara.

new.world_data <- world_data[(!is.na(world_data$pop_est)), ]

ggplot(data = new.world_data) +

geom_sf(color = "black", aes(fill = pop_est)) +

labs(title = paste("World Map:", length(unique(new.world_data$name)), "countries"),

x = "Longitude",

y = "Latitude",

fill = "Estimate Total Population") +

scale_fill_gradient(low = "grey", high = "red") +

theme_minimal()

Membuat spatial map di atas menjadi interaktif (interactive spatial map)

# membuat kolom baru yang berisi teks yang akan ditampilkan saat dilakukan hovering

new.world_data <- new.world_data %>%

mutate(text = glue("Country: {name}

Total Population: {pop_est}"))

# melakukan assignment spatial map ke dalam objek baru

interactive_map <- ggplot(data = new.world_data) +

geom_sf(color = "black", aes(fill = pop_est, text = text)) +

labs(title = paste("World Map:", length(unique(new.world_data$name)), "countries"),

x = "Longitude",

y = "Latitude",

fill = "Estimate Total Population") +

scale_fill_gradient(low = "grey", high = "red") +

theme_minimal()

ggplotly(interactive_map, tooltip = "text")2.1.3 Scale

2.1.3.1 Bagaimana cara memberi big mark pada axis plot?

untuk memberikan big mark pada axis dapat dibantu dengan package scales

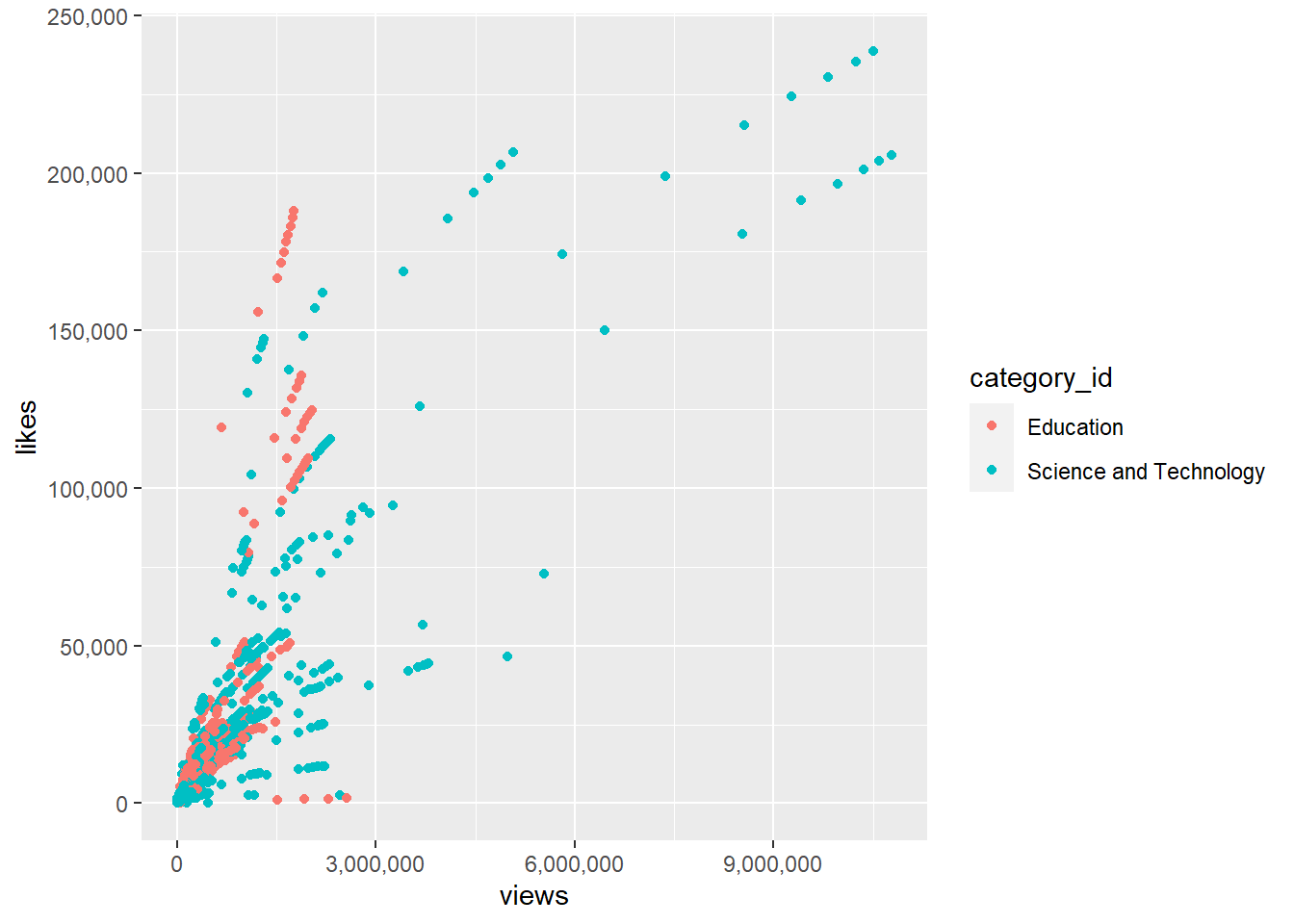

ggplot(vids3, aes(views, likes)) +

geom_point(aes(color = category_id)) +

scale_y_continuous(labels = comma)+

scale_x_continuous(labels = comma)

2.1.3.2 Apakah pengaturan label baik pada sumbu x ataupun y dapat dilakukan secara terpisah? misal kita ingin memeberikan label ribuan (1 ribu, 2 ribu, dst). Namun, pada angka 0 tidak ingin diikuti oleh “ribuan”.

Tidak bisa dilakukan secara terpisah, karena parameter labels pada fungsi scale_y_continous akan menambahkan satuan pada semua nilai label. Alternatif lain yang dapat dilakukan adalah membuat judul (title) pada sumbu x ataupun y dengan disertai oleh satuan. Misal, “Dislikes (Ribu)”, kemudian membuat skalanya menjadi lebih kecil (50000 menjadi 50 saja).

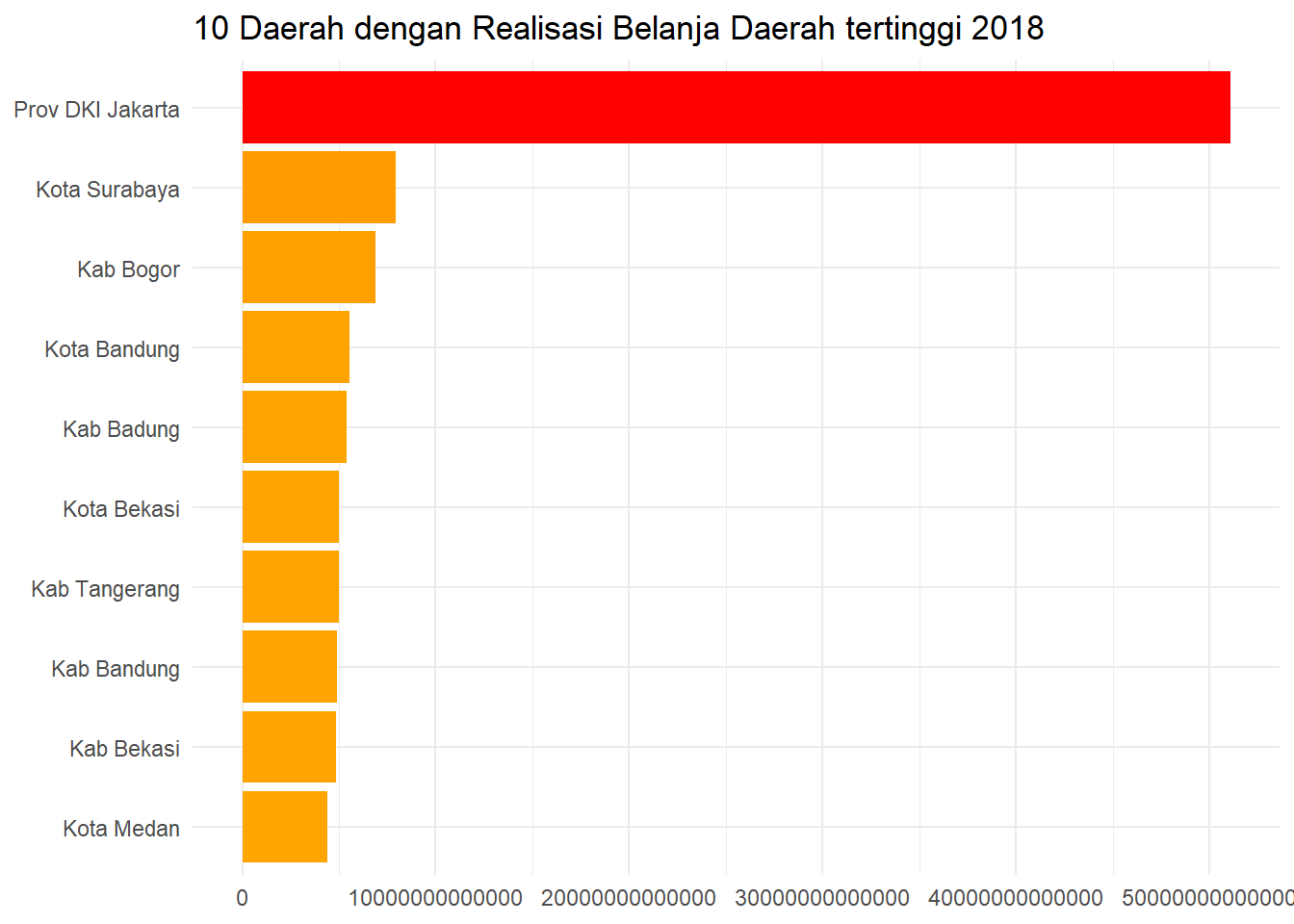

2.1.3.3 Bagaimana mengatasi axis yang memiliki satuan besar seperti berikut ini?

ggplot(data_agg, aes(x = belanja_daerah, y = reorder(daerah, belanja_daerah))) +

geom_col(aes(fill = belanja_daerah)) +

scale_fill_continuous(low = "orange", high = "red") +

guides(fill = FALSE) +

labs(

title = "10 Daerah dengan Realisasi Belanja Daerah tertinggi 2018",

x = NULL,

y = NULL

) +

theme_minimal()

Ketika kita melakukan visualisasi, adanya satuan axis yang cukup banyak tersebut dapat menyulitkan audience dalam memahami informasi pada grafik tersebut. Kita dapat mengatur scale axis pada plot tersebut dengan bantuan package scales. Berikut ini kita akan membuat object yang berisikan function label untuk merapihkan axis text pada plot:

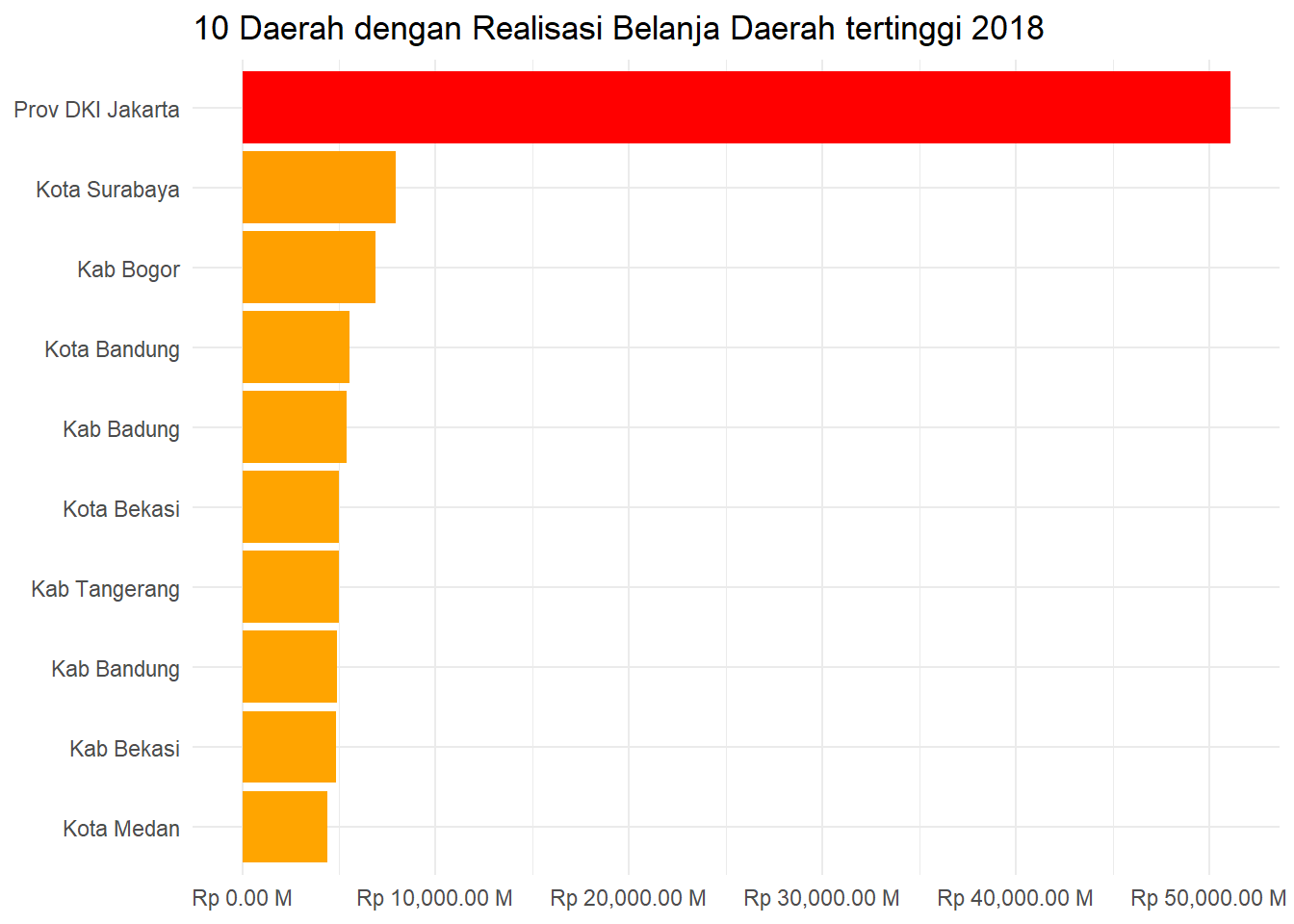

Selanjutnya, aplikasikan label tersebut pada function scale_y_continuous()

ggplot(data_agg, aes(x = belanja_daerah, y = reorder(daerah, belanja_daerah))) +

geom_col(aes(fill = belanja_daerah)) +

scale_x_continuous(labels = label_rupiah)+

scale_fill_continuous(low = "orange", high = "red") +

guides(fill = FALSE) +

labs(

title = "10 Daerah dengan Realisasi Belanja Daerah tertinggi 2018",

x = NULL,

y = NULL

) +

theme_minimal()

Setelah diaplikasikan label pada axis text terlihat lebih mudah dipahami informasi yang disampaikan pada grafik tersebut.

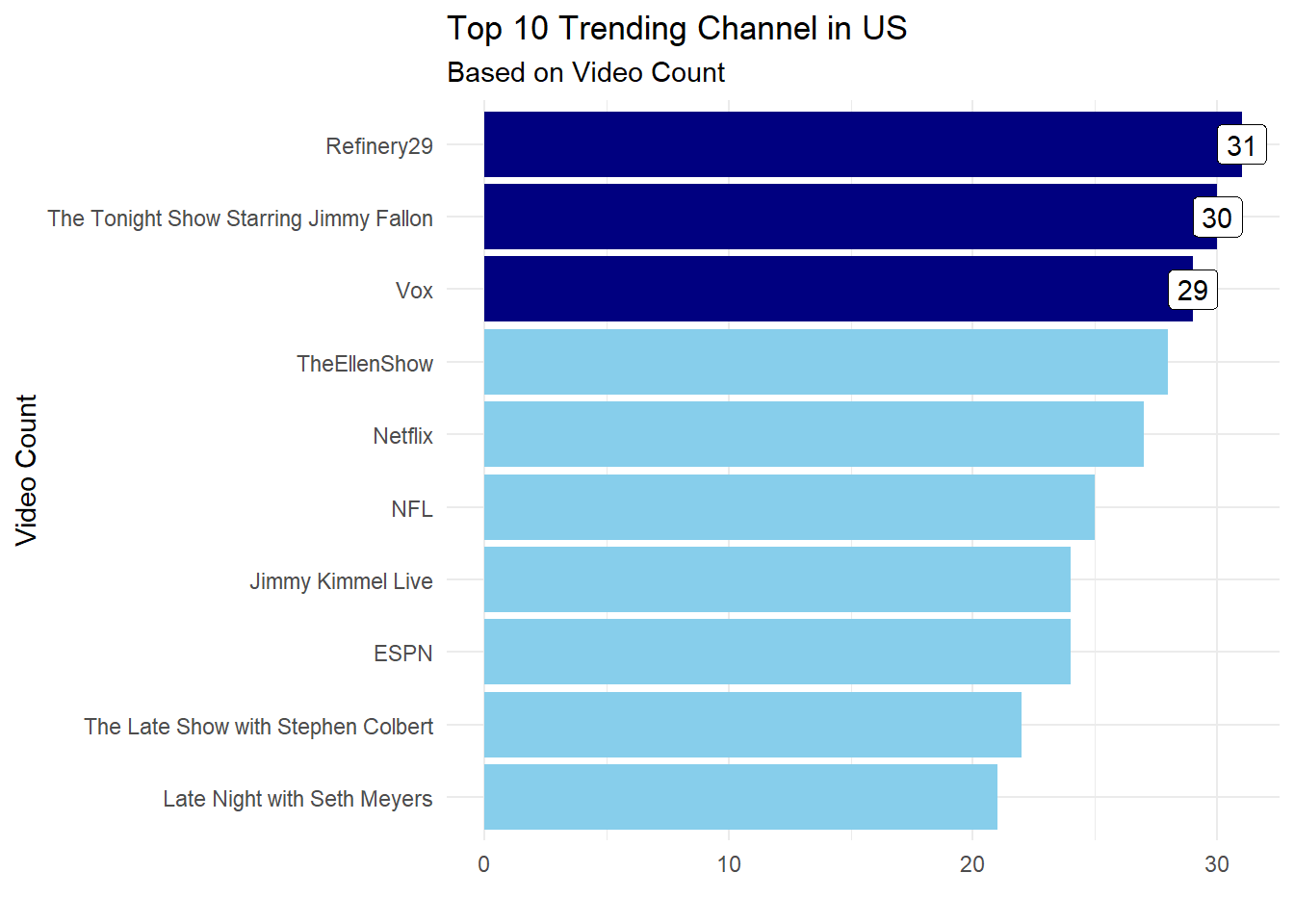

2.1.3.4 Bagaimana cara untuk mewarnai dan memberi label pada bar tertentu pada plot?

Misalkan, pada data top 10 trending channel akan dibentuk bar plot dan kita akan membedakan warna pada top 3 channel tersebut. Untuk pewarnaan dari top 3 channel kita memerlukan geom_col() tambahan yang berisi 3 data awal yang akan ditampilkan, begitupun pada geom_label() pada parameter data kita define observasi mana saja yang ingin diberikan label.

#> # A tibble: 10 x 2

#> channel_title total

#> <chr> <int>

#> 1 Refinery29 31

#> 2 The Tonight Show Starring Jimmy Fallon 30

#> 3 Vox 29

#> 4 TheEllenShow 28

#> 5 Netflix 27

#> 6 NFL 25

#> 7 ESPN 24

#> 8 Jimmy Kimmel Live 24

#> 9 The Late Show with Stephen Colbert 22

#> 10 Late Night with Seth Meyers 21ggplot(data = vids.top,mapping = aes(x = total,

y = reorder(channel_title,total)))+

geom_col(fill = "skyblue")+

geom_col(data = vids.top[1:3,], fill = "navy")+

geom_label(data = vids.top[1:3,],

mapping = aes(label = total))+

labs(title = "Top 10 Trending Channel in US",

subtitle = "Based on Video Count",

x = "",

y = "Video Count")+

theme_minimal()

2.1.4 Theme

2.1.4.1 Secara umum elemen-elemen apa saja yang dapat diatur/disesuaikan pada fungsi theme()?

Berikut adalah gambaran elemen-elemen apa saja yang dapat diatur/disesuaikan dengan fungsi theme()

plot.background: digunakan untuk menyesuaikan/mengatur warna background plot/kanvas. Digunakan dengan menambahkan parameterelement_rectuntuk menyesuaikan warna background yang diinginkan (colour).plot.margin: digunakan untuk memberi jarak antara kanvas utuh dengan kotak tempat plot berada. Digunakan dengan menambahkan parameterunit.plot.title: digunakan untuk menyesuaikan/mengatur elemen yang berkaitan dengan judul plot. Digunakan dengan menambahkan parameterelement_text()untuk mengatur spesifikasi tulisan yang diinginkan mulai dari ukuran (size), rata kiri-kanan/alignment (hjust), cetak tebal/miring (face), dll.plot.subtitle: digunakan untuk menyesuaikan/mengatur elemen yang berkaitan dengan sub-judul plot. Digunakan dengan menambahkan parameterelement_text()untuk mengatur spesifikasi tulisan yang diinginkan mulai dari ukuran (size), rata kiri-kanan/alignment (hjust), cetak tebal/miring (face), dll.axis.title.x: digunakan untuk menyesuaikan/mengatur elemen yang berkaitan dengan judul pada bagian sumbu x (horizontal). Digunakan dengan menambahkan parameterelement_text()untuk mengatur spesifikasi tulisan yang diinginkan mulai dari ukuran (size), rata kiri-kanan/alignment (hjust), cetak tebal/miring (face), dll.axis.text.x: digunakan untuk menyesuaikan/mengatur elemen yang berkaitan dengan tulisan pada bagian sumbu x (horizontal). Digunakan dengan menambahkan parameterelement_text()untuk mengatur spesifikasi tulisan yang diinginkan mulai dari ukuran (size), rata kiri-kanan/alignment (hjust), cetak tebal/miring (face), dll.axis.title.y: kegunaanya sama persis seperti parameteraxis.title.x, perbedaanya adalah digunakan pada sumbu y (vertikal).axis.text.y: kegunaanya sama persis seperti parameteraxis.text.x, perbedaanya adalah digunakan pada sumbu y (vertikal).panel.background: digunakan untuk mengubah warna panel background, dengan menambahkan parameterelement_rectuntuk menyesuaikan warna panel background yang diinginkan (colour).panel.grid: digunakan untuk mengubah tampilan garis kisi (grid) pada plot. Digunakan dengan menambahkan parameterelement_lineuntuk mengatur warna garis (colour), tipe garis (linetype), ukuran garis (size), dll.plot.caption: digunakan untuk menyesuaikan/mengatur elemen yang berkaitan dengan caption plot (tulisan tambahan yang terletak pada bagian bawah plot). Digunakan dengan menambahkan parameterelement_text()untuk mengatur spesifikasi tulisan yang diinginkan mulai dari ukuran (size), rata kiri-kanan/alignment (hjust), cetak tebal/miring (face), dll.legend.title: digunakan untuk menyesuaikan/mengatur elemen yang berkaitan dengan judul legend. Digunakan dengan menambahkan parameterelement_text()untuk mengatur spesifikasi tulisan yang diinginkan mulai dari ukuran (size), rata kiri-kanan/alignment (hjust), cetak tebal/miring (face), dll.legend.background: digunakan untuk mengubah warna background legend, dengan menambahkan parameterelement_rectuntuk menyesuaikan warna panel background yang diinginkan (colour).legend.position: digunakan untuk mengatur letak/posisi legend pada plot, digunakan dengan menambahakan parameternone,left,right,bottom, dantoplegend.text: digunakan untuk menyesuaikan/mengatur elemen yang berkaitan dengan tulisan pada bagian legend. Digunakan dengan menambahkan parameterelement_text()untuk mengatur spesifikasi tulisan yang diinginkan mulai dari ukuran (size), rata kiri-kanan/alignment (hjust), cetak tebal/miring (face), dll.

2.1.4.2 Bagaimana cara mengatur posisi legend secara manual (selain menggunakan position default “none”, “left”, “right”, “bottom”, dan “top”) supaya posisinya berada di dalam kanvas plotnya?

Untuk mengatur posisi legend secara manual dapat menambahakan parameter legend.position pada theme seperti berikut ini:

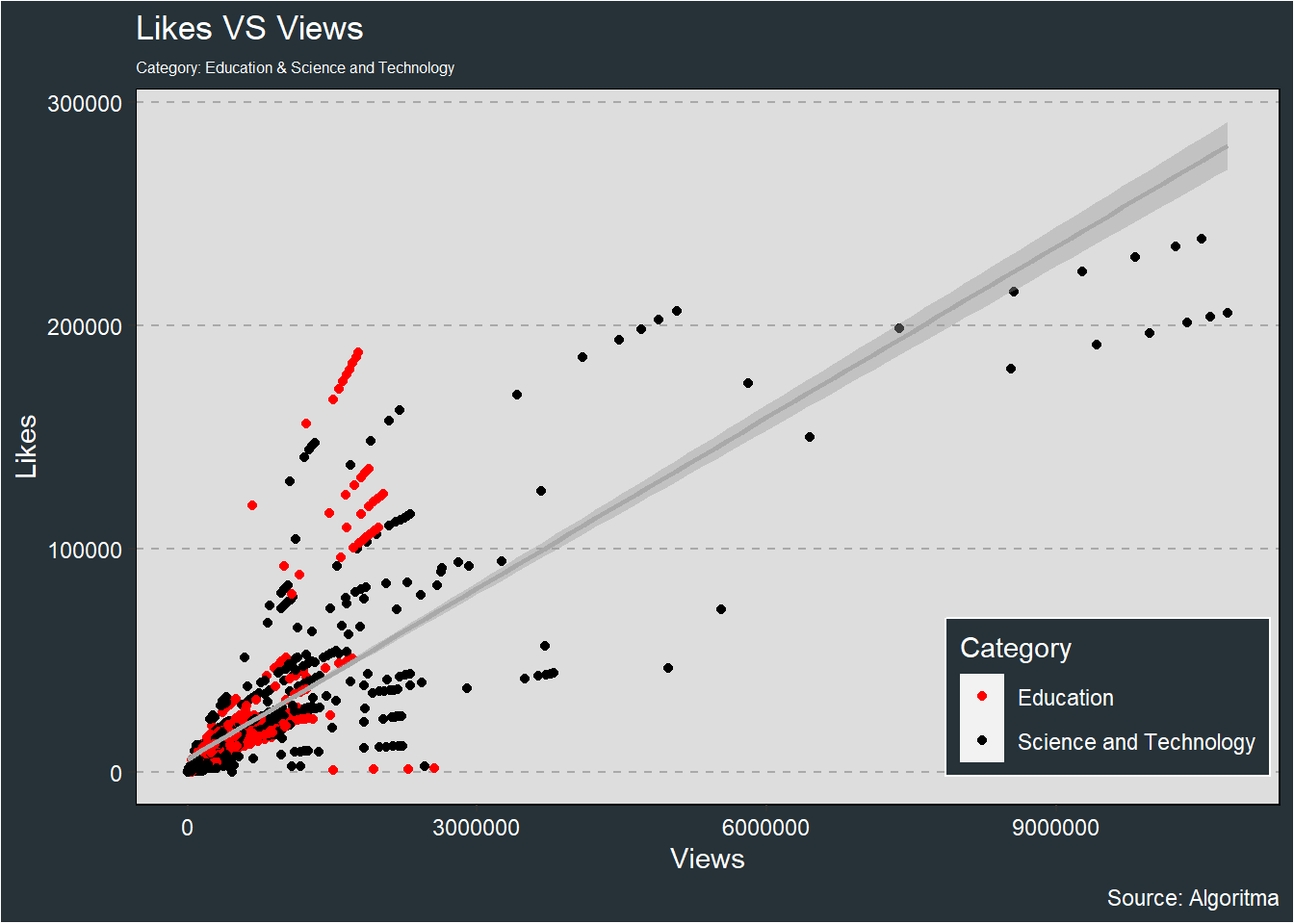

vids3 <- vids %>%

select(channel_title, category_id, views, likes) %>%

filter(category_id %in% c("Education", "Science and Technology"))theme_algoritma <- theme(legend.background = element_rect(color="white", fill="#263238"),

plot.subtitle = element_text(size=6, color="white"),

panel.background = element_rect(fill="#dddddd"),

panel.border = element_rect(fill=NA),

panel.grid.minor.x = element_blank(),

panel.grid.major.x = element_blank(),

panel.grid.major.y = element_line(color="darkgrey", linetype=2),

panel.grid.minor.y = element_blank(),

plot.background = element_rect(fill="#263238"),

text = element_text(color="white"),

axis.text = element_text(color="white"))ggplot(vids3, aes(views, likes)) +

geom_point(aes(color = category_id)) +

geom_smooth(method = "lm", color = "darkgrey") +

labs(title = "Likes VS Views",

subtitle = "Category: Education & Science and Technology",

x = "Views",

y = "Likes",

caption = "Source: Algoritma",

col = "Category") +

scale_color_manual(values = c("red", "black")) +

theme(legend.position = c(0.85, 0.15)) +

theme_algoritma

2.2 Interactive plotting

2.2.0.1 Contoh penggunaan echarts4r untuk beberapa plot sederhana

- Line Plot

vids2 <- vids %>%

select(trending_date, channel_title, category_id) %>%

filter(category_id %in% c("Education", "Science and Technology"),) %>%

group_by(trending_date, category_id) %>%

summarise(total.video = n()) %>%

ungroup()vids2 %>%

group_by(category_id) %>%

e_charts(trending_date) %>%

e_line(total.video) %>%

e_legend(F) %>%

e_title("Trend Total Video Trending based on Category")- Area charts

vids2 %>%

group_by(category_id) %>%

e_charts(trending_date) %>%

e_area(total.video) %>%

e_legend(F) %>%

e_title("Trend Total Video Trending based on Category")- Bar plot

vids1 %>%

e_charts(channel_title) %>%

e_bar(total.likes) %>%

e_legend(F) %>%

e_title("Top 5 Channel based on Total Likes")- Scatter plot

vids3 %>%

group_by(category_id) %>%

e_charts(views) %>%

e_scatter(likes) %>%

e_title("Likes VS Views")- Heatmap

retail <- read.csv("data/02-DVIP/retail.csv")

retail.agg1 <- retail %>%

group_by(Sub.Category, Ship.Mode) %>%

summarise(Sales = sum(Sales)) %>%

ungroup()retail.agg1 %>%

e_charts(Ship.Mode) %>%

e_heatmap(Sub.Category, Sales) %>%

e_visual_map(Sales) %>%

e_title("Heatmap") %>%

e_legend(type = c("scroll"))- Treemap

2.2.0.2 Bagaimana cara membuat e-charts menjadi interaktif?

2.2.0.3 Contoh penggunaan highcharter untuk beberapa plot sederhana:

- Scatter plot

hchart(vids3, "scatter", hcaes(x = views, y = likes, group = category_id)) %>%

hc_title(text = "Likes VS Views") %>%

hc_subtitle(text = "Category: Education & Science and Technology")- Bar Plot

hchart(vids1, "column", hcaes(x = channel_title, y = total.likes)) %>%

hc_title(text = "Top 5 Channel based on Total Likes") %>%

hc_subtitle(text = "Category: Education & Science and Technology")- Line Plot

2.2.0.4 Bagaimana cara untuk menampilkan pop-up informasi dari grafik?

Untuk membuat plot menjadi interactive, kita dapat menggunakan package glue dan plotly.

#> # A tibble: 10 x 2

#> daerah belanja_daerah

#> <chr> <dbl>

#> 1 Prov DKI Jakarta 51066081000000

#> 2 Kota Surabaya 7912409000000

#> 3 Kab Bogor 6875742000000

#> 4 Kota Bandung 5541718000000

#> 5 Kab Badung 5413936000000

#> 6 Kota Bekasi 4982355000000

#> 7 Kab Tangerang 4981819000000

#> 8 Kab Bandung 4911936000000

#> 9 Kab Bekasi 4846112000000

#> 10 Kota Medan 4395825000000Berikut ini kita akan membuat kolom baru bernama tooltip, gunakan function glue() untuk mendefinisikan informasi yang akan ditampilkan. Pada variable “belanja_daerah” yang ditampilkan diberikan function label_rupiah() yang sudah dibuat pada pembahasan sebelumnya agar tampilan menjadi lebih rapih.

# Prepare data for visualization

data_viz <- data_agg %>%

mutate(tooltip = glue("Belanja daerah: {label_rupiah(belanja_daerah)}"))

head(data_viz)#> # A tibble: 6 x 3

#> daerah belanja_daerah tooltip

#> <chr> <dbl> <glue>

#> 1 Prov DKI Jakarta 51066081000000 Belanja daerah: Rp 51,066.08 M

#> 2 Kota Surabaya 7912409000000 Belanja daerah: Rp 7,912.41 M

#> 3 Kab Bogor 6875742000000 Belanja daerah: Rp 6,875.74 M

#> 4 Kota Bandung 5541718000000 Belanja daerah: Rp 5,541.72 M

#> 5 Kab Badung 5413936000000 Belanja daerah: Rp 5,413.94 M

#> 6 Kota Bekasi 4982355000000 Belanja daerah: Rp 4,982.36 MUntuk memberikan hovertext pada setiap bar, kita dapat gunakan parameter text dan isi dengan nama kolom yang akan ditampilkan. Selanjutkan, gunakan function ggplotly() untuk membuat plot menjadi interactive, parameter tooltip digunakan untuk mengatur informasi yang akan ditampilkan. Secara default, dia akan menampilkan semua informasi yang ada pada parameter aes, ketika kita define “text” artinya kita akan menampilkan informasi dari parameter text.

# Visualization

p <- ggplot(data_viz, aes(x = belanja_daerah, y = reorder(daerah, belanja_daerah))) +

geom_col(aes(fill = belanja_daerah, text = tooltip)) +

scale_x_continuous(labels = label_rupiah) +

scale_fill_continuous(low = "orange", high = "red") +

guides(fill = FALSE) +

labs(

title = "10 Daerah dengan Realisasi Belanja Daerah tertinggi 2018",

x = NULL,

y = NULL

) +

theme_minimal()

ggplotly(p, tooltip = "text")2.2.0.5 Apakah plotly juga dapat diatur/disesuaikan secara terpisah dari ggplot2?

Bisa, berikut beberapa contoh pengaturan pada plotly:

- Menghapus logo

plotlypadamode bar

- Menghapus semua button (termasuk logo

plotly) padamode bar

- Range selector

- Scroll with pan mode for zooming

2.3 Leaflet

Kunjungi halaman berikut untuk Section Leaflet.

Bab 3 Practical Statistics

3.1 Statistika Deskriptif

3.1.1 Kekurangan nilai rata-rata (mean) adalah sensitif terhadap data ekstrim (outlier). Apakah kekurangan dari median?

- Median jarang digunakan dalam inferensial statistik karena tidak melibatkan semua data, sedangkan dalam mengambil keputusan dengan menggunakan tes/uji statistik semua data harus dilibatkan.

- Sebenarnya mean dan median bukan merupakan sesuatu yang harus dipilih. Keduanya bisa saja digunakan dalam proses eksplorasi data. Ketika kita melihat ringkasan dari data dan ternyata nilai mean jauh berbeda dengan nilai mediannya, maka hal tersebut dapat dijadikan salah satu indikator adanya outlier.

3.1.2 Apakah modus dapat digunakan untuk data bertipe numerik?

Bisa, hanya saja informasi yang diperoleh kurang representatif pada data bertipe numerik kontinu (desimal).

3.1.3 Apakah bisa menggunakan nilai mutlak/absolut saat menghitung variance, sebagai pengganti kuadrat?

Apabila menggunakan nilai mutlak/absolut saat menjumlahkan jarak dari setiap observasi ke pusat data (mean), maka ukuran tersebut disebut sebagai mean absolute deviation (rata-rata absolut deviasi).

3.1.4 Saat menghitung variance, kita menggunakan nilai mean sebagai pusat datanya. Ketika terdapat outlier, bukankah lebih tepat jika pusat datanya menggunakan median untuk menghitung variance?

Sesuai rumus variance, pusat data yang digunakan adalah mean. Tidak masalah walaupun terdapat outlier, karena nilai variance juga akan semakin membesar. Hal tersebut menunjukkan bahwa data kita semakin beragam/bervariasi karena adanya outlier.

3.1.5 Bagaimana menentukan suatu observasi merupakan outlier secara objektif?

Salah satu cara yang dapat digunakan untuk menentukan suatu observasi merupakan outlier/tidak adalah dengan menggunakan boxplot (melihat apakah suatu observasi berada di luar interval batas bawah (Q1 - 1.5 IQR) dan batas atas (Q3 + 1.5 IQR))

3.1.6 Apakah terdapat korelasi/keterkaitan antara mean dengan standar deviasi?

Tidak ada, karena mean adalah nilai yang menggambarkan pusat data (nilai yang merangkum keseluruhan data). Sedangkan, standar deviasi adalah nilai yang mengambarkan persebaran data (apakah data cenderung bervariasi/beragam)

3.1.7 Apakah pada R terdapat fungsi yang dapat digunakan untuk menentukan apakah dua variabel numerik memiliki hubungan linier atau tidak?

Kita dapat menggunakan fungsi cor() untuk menghitung nilai korelasi dan cor.test() untuk melakukan tes/uji statistik untuk mengetahui apakah dua variabel numerik saling berhubungan linier atau tidak dengan hipotesis sebagai berikut:

- H0: Nilai korelasi = 0, berarti antara x dan y tidak memiliki hubungan linier

- H1: Nilai korelasi != 0, berarti antara x dan y memiliki hubungan linier

3.1.8 Apa fungsi yang digunakan untuk menghitung nilai- rata-rata geometrik dan terboboti pada R?

Kita dapat menggunakan fungsi geometric.mean() dan weighted.mean(), untuk lebih jelasnya dapat membaca dokumentasi pada link berikut:

3.1.9 Apa yang dimaksud dengan outlier? Jelaskan!

Observasi yang nilainya sangat jauh berbeda dengan observasi lainnya baik sebagai variabel tunggal ataupun kombinasi.

3.2 Statistika Inferensial

3.2.1 Apabila data populasi tidak berdistribusi normal, apakah berpengaruh terhadap sampling rata-rata?

Central Limit Theorem (CLT) menyatakan bahwa apapun bentuk distribusi data populasi, ketika dilakukan sampling dengan jumlah yang cukup banyak dan dilakukan berulang kali, maka distribusi rata-rata sampel akan mendekati distribusi normal. Sehingga, ketika data populasi tidak berdistribusi normal, tidak akan berpengaruh terhadap distribusi rata-rata sampel selama jumlah sampel cukup (umumnya di atas 30) dan dilakukan berulang kali.

3.2.2 Contoh kegunaan Probability Mass Function dalam dunia nyata?

- Mengetahui proporsi jumlah produk yang cacat dalam proses produksi

- Mengetahui proporsi nasabah yang pengajuan pinjamannya disetujui

- Mengetahui distribusi banyaknya pelanggan yang datang ke toko setiap jamnya

- Mengetahui distribusi antrian di setiap kasir pada suatu toko

3.2.3 Dalam ilmu statistik berapa minimal jumlah sampel dapat dikatakan cukup?

Berdasarkan Central Limit Theorem (CLT) jumlah sampel sudah dikatakan cukup jika sudah mencapai 30 observasi.

3.2.4 Apakah hipotesis nol (H0) pasti merupakan dugaan/hipotesa negatif?

Tidak, tergantung kasus yang akan diuji. Hipotesis nol (H0) mengindikasikan keadaan awal atau kedaan yang tidak mengalami perubahan respon walaupun telah dilakukan suatu perlakuan.

3.2.5 Bagaimana cara melakukan tes/uji hipotesis ketika sampel data tidak berdistribusi normal?

Kita tetap dapat melakukan tes/uji hipotesis menggunakan tes/uji non-parametrik yang tidak mengharuskan sampel data berdistribusi normal, seperti Wilcoxon test untuk tes/uji hipotesis 1 sampel dan Mann-Whitney test untuk tes/uji hipotesis 2 sampel.

3.2.6 Jika ingin mengetahui pengaruh sistem kerja WFH terhadap kinerja karyawan menimbulkan efek positif/negatif/tidak ada efek, bagaiamana penentuan hipotesisnya?

- H0: Sistem kerja WFH tidak berpengaruh terhadap kinerja karyawan

- H1: Sistem kerja WFH berpengaruh terhadap kinerja karyawan (dapat berupa pengaruh positif ataupun negatif)

3.2.7 Perbedaan fungsi pnorm() dan qnorm()?

- Fungsi

pnorm()digunakan untuk memperoleh nilai peluang ketika diketahui nilai z-score (z-score -> peluang). Sedangkan, - fungsi

qnorm()kebalikan dari fungsipnorm(), digunakan untuk memperoleh nilai z-score ketika diketahui nilai peluang (peluang -> z-score)

3.2.8 Apa maksud dari pernyataan “Gagal tolak H0 != Terima H0 dan Tolak H0 != Terima H1”?

Ketika kita melakukan tes/uji hipotesis, hal yang kita peroleh sebenarnya adalah melihat bahwa data sampel yang dimiliki “menyimpang sangat ekstrem”. Sehingga, kita hendak mengambil kesimpulan bahwa sampel “dapat dikatakan signifikan”.

Pada tes/uji hipotesis, menolak H0 dapat dikatakan sebagai pemberian bukti sementara penerimaan H1. Secara absolut hanya dapat dilakukan ketika kita sudah mengecek data populasi , tetapi hal tersebut hampir tidak mungkin dilakukan. Sehingga, penggunaan bahasa yang tepat adalah “menolak H0” bukan bearti “menerima H1”

3.2.9 Berapa batasan nilai korelasi dikatakan kuat dan lemah?

Semakin mendekati 0, berarti korelasi cenderung lemah dan sebalikanya. Semakin mendekati 1, berarti korelasi cnderung kuat. Pada umumnya, jika nilai korelasi di bawah 0.5, berarti korelasi cenderung lemah dan sebaliknya. Jika nilai korelasi di atas 0.5, berarti korelasi cenderung kuat. Untuk mengetahui apakah nilai korelasi di bawah 0.5, sebenarnya berkorelasi lemah atau tidak berkorelasi dapat dipastikan dengan melakukan tes/uji statistik menggunakan fungsi cor.test()

3.2.10 Jika sampel data tidak berdistribusi normal, apakah z-score standarization dengan fungsi scale() masih tetap dapat digunakan?

Jika tujuannya hanya untuk melakukan scaling pada data (memperkecil interval pada data bertipe numerik) kita tetap dapat menggunakan z-score standarization walaupun sampel data tidak bersitribusi normal. Tetapi, ketika tujuannya adalah menghitung peluang, maka perhitungan z-score kurang tepat digunakan.

3.2.11 Jika nilai p-value yang diperoleh sama dengan nilai alpha yang digunakan, apakah kesimpulan yang dipilih tolak H0 atau gagal tolak H0?

Pada kasus nilai p-value sama dengan nilai alpha, secara aplikatif umumnya kesimpulan yang dipilih adalah tolak H0. Namun, ada baiknya menambah jumlah sampel untuk memperoleh dan memastikan kesimpulan yang diambil tidak menimbulkan kondisi yang ambigu.

3.2.12 Terdapat sumber yang mengatakan bahwa formula untuk menghitung z-score adalah , apakah formula tersebut benar?

Formula tersebut benar untuk menghitung z-score tes/uji hipotesis rata-rata 1 sampel.

3.2.13 Bagaimana cara melakukan tes/uji hipotesis untuk proporsi?

Fungsi yang digunakan masih sama seperti melakukan tes/uji hipotesis rata-rata, yaitu pnorm(), namun formula untuk menghitung z-score yang digunakan berbeda. Sehingga, harus dilakukan perhitungan z-score terlebih dahulu dengan formula

Dengan adalah proporsi sampel, adalah proporsi populasi, dan adalah jumlah sampel yang diuji/dites. Selanjutnya nilai z-score tersebut yang di-input pada fungsi pnorm().

3.2.14 Mengapa jika tingkat alpha pada confidence interval semakin mendekati 0 (confidence interval 100%), selisih nilai batas bawah dan batas atas semakin besar?

Semakin kecil tingkat alpha, maka interval/selisih batas bawah dan batas atas pada confidence interval akan semakin besar, yang artinya rentang nilai prediksi semakin lebar. Secara sederhana, jika error yang ditoleransi mendekati 0%, maka nilai prediksi harus berada dalam interval/selisih batas bawah dan batas atas pada confidence interval. Supaya memenuhi syarat tersebut, maka interval harus dibuat semakin lebar untuk memastikan bahwa nilai prediksi berada di dalam interval tersebut.

3.2.15 Apakah taraf kepercayaan pada confidence interval selalu 95%?

Taraf kepercayaan 95% atau alpha 5% adalah taraf kepercayaan atau alpha yang sering digunakan oleh user. Taraf kepercayaan ataupun alpha yang digunakan sebenarnya boleh di angka berapa pun bergantung pada sudut pandan bisnis dan pemrasalahan yang dianalisis. Misal, untuk permasalahan di bidang kesehatan atau transportasi diharapkan error yang dihasilkan sekecil mungkin karena berkaitan dengan jiwa seseorang, maka biasanya digunakan taraf kepercayaan 99% atau alpha 1%.

Bab 4 Regression Model

4.1 Linear Regression

4.1.1 Bagaimana model regresi linier dengan fungsi lm() bekerja jika terdapat prediktor bertipe kategorik?

Fungsi lm() pada R akan secara otomatis mengubah prediktor bertipe kategorik menjadi variabel dummy. Variabel dummy adalah hasil transformasi prediktor kategorik berupa nilai 0 atau 1 untuk menggambarkan ada/tidaknya suatu kategori (metode untuk mengkuantitatifkan prediktor bertipe kategorik). Jika terdapat kategori pada suatu prediktor bertipe kategori, maka akan dihasilkan sejumlah variabel dummy. Misal, jika terdapat 1 kolom berisi prediktor bertipe kategorik yang menggambarkan tingkat salary dari setiap pelanggan sebagai berikut

#> salary_level

#> 1 High

#> 2 Low

#> 3 Medium

#> 4 Low

#> 5 HighMaka, akan dihasilkan 2 variabel dummy seperti berikut

#> salary_level_Low salary_level_Medium

#> 1 0 0

#> 2 1 0

#> 3 0 1

#> 4 1 0

#> 5 0 04.1.2 Jika pada hasil summary model regresi linier terdapat salah satu level/kategori dari prediktor bertipe kategorik yang tidak signifikan mempengaruhi target variabel (p-value < alpha), apakah prediktor tersebut signifikan mempengaruhi target variabel atau tidak?

Keadaan tersebut biasanya disebabkan oleh jumlah sampel untuk level/kategori tersebut tidak cukup banyak dibandingkan dengan jumlah sampel level/kategori lainnya. Kesimpulan signifikan atau tidaknya kembali pada masing-masing user dengan mempertimbangkan sudut pandang bisnis dan permasalahan yang dianalisis. Namun, salah satu solusi yang dapat dicoba adalah menggabungkan sampel dengan level/kategori tersebut dengan level/kategori lainnya yang memiliki karakteristik yang serupa.

4.1.3 Fungsi lm() akan secara otomatis mengubah prediktor bertipe kategorik menjadi variabel dummy dimana level/kategori paling awal akan dijadikan sebagai basis (dihilangkan). Apakah hasil analisis model regresi linier akan berubah, jika dilakukan pengurutan ulang (reorder) level/kategori dari suatu prediktor bertipe kategorik?

Hasil analisis model regresi linier yang diperoleh tidak akan berubah, melakukan pengurutan ulang level/kategori dari suatu prediktor numerik hanya akan mengubah basis yang digunakan.

4.1.4 Jika pada hasil summary model regresi linier terdapat prediktor yang tidak signifikan, apakah prediktor tersebut lebih baik tidak diikutsertakan dalam model regresi linier atau sebaliknya?

Hal tersebut bergantung pada sudut pandang bisnis dan permasalahan yang dianalisis, jika berdasarkan sudut pandang bisnis prediktor tersebut harus diketahui bagaimana dan seberapa besar pengaruhnya terhadapap target variabel. Maka, tetap dapat diikutsertakan. Namun, jika berdasarkan sudut pandang bisnis tidak terlalu mempengaruhi target variabel, maka boleh tidak diikutsertakan dengan tujuan supaya model regresi linier yang dihasilkan menjadi lebih sederhana. Solusi lain yang dapat dipertimbangkan untuk dilakukan adalah menambah jumlah sampel atau membuang observasi yang merupakan outlier dan berpengaruh negatif terhadap hasil analisisi regresi linier. Hal ini dapat dipertimbangkan untuk dilakukan karena suatu prediktor tidak signifikan mempengaruhi target tidak hanya karena antara prediktor dengan target tidak saling mempengaruhi dan dipengaruhi, melainkan juga karena beberapa faktor seperti variansi data yang rendah atau karena terdapat observasi outlier yang justru berpengaruh negatif terhaddap hasil analisis regresi linier.

4.1.5 Apa saja cara yang dapat dilakukan untuk memperbaiki model regresi linier (tuning)?

Berikut beberapa cara yang dapat dilakukan untuk memperbaiki model regresi linier:

- Deteksi observasi outlier

- Pengaruh negatif terhadap model regresi linier sebaiknya observasi tersebut tidak diikutsertakan

- Pengaruh positif terhadap model regresi linier sebaiknya observasi tersebut tetap dapat diikutsertakan

- Menambah prediktor berdasarkan informasi dari prediktor yang sudah ada (feature engineering)

- Melakukan transformasi data

- Mengubah prediktor bertipe numerik menjadi kategorik

- Melakukan transformasi pada prediktor bertipe numerik dengan operasi matematika seperti log, ln, sqrt, kuadrat, dll

4.1.6 Apa kegunaan nilai p-value pada hasil summary model regresi linier, padahal biasanya dilakukan pemeriksaan nilai korelasi atau tes/uji korelasi sebelum melakukan pemodelan regresi linier?

Memeriksa nilai korelasi atau melakukan tes/uji korelasi bertujuan untuk melihat keterkaitan antara prediktor dengan target variabel, dimana secara logika (hipotesis) variabel yang saling berkaitan ada kemungkinan untuk saling mempengaruhi dan dipengaruhi. Sementara, nilai p-value pada hasil summary model regresi linier digunakan untuk mengkonfirmasi apakah antara prediktor dan target saling mempengaruhi dan dipengaruhi. Sebab, korelasi hanya menyatakan keterkaitan antar variabel saja, bukan menjelaskan hubungan sebab dan akibat.

4.1.6.1 Apakah regresi linier dapat dilakukan jika target variabel bertipe numerik diskrit?

Bisa saja, namun hasil prediksinya kurang tepat karena menghasilkan nilai numerik kontinu yang kemungkinan menghasilkan error yang lebih besar. Model regresi yang lebih cocok digunakan untuk kondisi tersebut adalah model regresi poisson, untuk penjelasan lengkapnya dapat membaca link referensi berikut Regresi Poisson

4.1.7 Apakah cukup dengan mengecek nilai korelasi atau harus dilakukan tes/uji korelasi untuk mengecek keterkaitan antara prediktor dengan target variabel?

Nilai korelasi di bawah -0.5 atau di atas 0.5 sudah dianggap bahwa antara prediktor dan target variabel memiliki keterkaitan/hubungan yang cukup kuat. Namun, sebaliknya nilai korelasi di antara -0.5 sampai 0.5 mengindikasikan bahwa antara prediktor dengan target saling berkaitan/berhubungan, tetapi hubungannya lemah. Sehingga, perlu dilakukan tes/uji korelasi untuk mengonfirmasi apakah hubungan antara prediktor dengan target variabel signifikan atau tidak secara statistik (objektif).

4.1.8 Hasil summary model regresi linier dari fungsi lm() memuat beberapa nilai seperti std.error, t-value, dan p-value. Apa kegunaan dari ketiga nilai tersebut?

Std.error dan t-value pada hasil summary model regresi linier digunakan untuk menghitung nilai p-value. Dimana nilai p-value digunakan untuk melakukan tes/uji hipotesis untuk menguji apakah prediktor signifikan mempengaruhi target variabel atau tidak. Hipotesis:

- H0: Prediktor tidak mempengaruhi target variabel

- H1: Prediktor mempengaruhi target variabel

Nilai p-value tersebut harus dibandingkan dengan alpha yang digunakan (p-value < alpha: prediktor signifikan mempengaruhi target variabel) untuk menarik kesimpulan apakah prediktor signifikan mempengaruhi target atau tidak. Namun, hasil summary model regresi linier di R sudah dilengkapi oleh simbol bintang yang mempermudah user untuk menarik kesimpulan. Jika minimal terdapat satu simbol bintang, maka prediktor signifikan mempengaruhi target variabel dengan alpha 5% (p-value < 0.05).

4.1.9 Bagaimana cara menampilkan nilai p-value pada output linear model (regresi linier)?

Output dari fungsi lm() di R dapat dilihat melalui fungsi summary(). Output tersebut berupa list yang dapat diakses sesuai dengan aturan indexing dan subsetting pada list.

#>

#> Call:

#> lm(formula = mpg ~ cyl, data = mtcars)

#>

#> Residuals:

#> Min 1Q Median 3Q Max

#> -4.9814 -2.1185 0.2217 1.0717 7.5186

#>

#> Coefficients:

#> Estimate Std. Error t value Pr(>|t|)

#> (Intercept) 37.8846 2.0738 18.27 < 0.0000000000000002 ***

#> cyl -2.8758 0.3224 -8.92 0.000000000611 ***

#> ---

#> Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

#>

#> Residual standard error: 3.206 on 30 degrees of freedom

#> Multiple R-squared: 0.7262, Adjusted R-squared: 0.7171

#> F-statistic: 79.56 on 1 and 30 DF, p-value: 0.0000000006113Untuk mengambil nilai pada index coefficient, dapat menggunakan fungsi summary(model)$coefficient yang akan menghasilkan output berupa matrix

#> Estimate Std. Error t value Pr(>|t|)

#> (Intercept) 37.88458 2.0738436 18.267808 0.000000000000000008369155

#> cyl -2.87579 0.3224089 -8.919699 0.000000000611268714258098Kemudian untuk mengambil p-value dari matrix di atas dapat menggunakan aturan indexing dan subsetting pada matrix, dimana nilai yang ingin diambil berada pada kolom ke-4

#> (Intercept) cyl

#> 0.000000000000000008369155 0.0000000006112687142580984.2 Evaluation

4.2.1 Apakah nilai AIC bisa negatif?

AIC dapat bernilai negatif atupun positif bergatung pada nilai maksimum likelihood yang diperoleh. Berikut formula untuk menghitung nilai AIC:

Dimana merupakan jumlah parameter yang diprediksi (prediktor dan intersep) dan $L% merupakan nilai maksimum likelihood yang diperoleh.

Namun, pemilihan model regresi linier pada metode stepwise regression tidak memperhatikan tanda negatif atau positif dari nilai AIC melainkan nilainya saja (absolut AIC). Sehingga, tanda negatif atau positif pada nilai AIC tidak berpengaruh dalam proses pemilihan model regresi linier pada metode stepwise regression. Model yang dipilih adalah model yang memiliki nilai abolut AIC terkecil yang mengindikasikan bahwa semakin sedikit informasi yang hilang pada model tersebut. Negative values for AIC

4.2.2 Apa perbedaan R-squared dan Adjusted R-squared?

- R-Squared: Seberapa baik model menjelaskan data, dengan mengukur seberapa besar informasi (variansi) dari target dapat dijelaskan oleh prediktor. Sehingga, jelas ketika prediktor bertmabah, informasi (variansi) yang dirangkum semakin banyak atau dengan kata lain jelas nilai R-Squared akan meningkat.

- Adj. R- Squared: tidak demikian pada adj. r-squared, karena disesuaikan dengan jumlah prediktor yang digunakan. Adj. r-squared akan meningkat hanya jika prediktor baru yang ditambahkan mengarah pada hasil prediksi yang lebih baik (prediktor signifikan mempengaruhi target)

Formula Adj. R-Squared:

Dimana, adalah jumlah sampel dan adalah jumlah prediktor.

4.2.3 Adakah batasan nilai R-squared yang dianggap baik?

Baik tidaknya nilai R-squared adalah relatif bergantung pada sudut pandang bisnis dan permasalahan yang dianalisis. Namun, umumnya nilai R-squared di atas atau sama dengan 70% sudah cukup baik dalam menjelaskan variansi dari target variabel.

4.2.4 Apakah hanya nilai AIC yang dapat digunakan untuk memilih model regresi linier pada stepwise regression?

Secara default fungsi stepwise() di R hanya menngunakan nilai AIC untuk memilih model regresi linier. Jika ingin membandingkan metrics evaluasi lain dapat menggunakan fungsi compare_performance() dari package performance untuk menampilkan beberapa nilai metrics evaluasi seperti R-squared, BIC, dll untuk setiap kombinasi model yang dibuat. Berikut beberapa alasan mengapa nilai AIC lebih diutmakan untuk memilih model regresi linier dibandingkan metrics lainnya Alasan Penggunaan nilai AIC

4.2.5 Stepwise regression memiliki 3 algoritma, yaitu backward, forward, dan both. Apakah ketiga algoritma tersebut memiliki fungsi yang sama?

Stepwise regression baik algoritma backward, forward, ataupun both memiliki fungsi yang sama, yaitu untuk melakukan pemilihan prediktor (variable selection) yang akan diikutsertakan dalam model regresi linier. Stepwise regession baik dengan algoritma backward, forward, ataupun both akan menghasilkan performa model yang hampir sama, namun ada baiknya sebagai user melakukan trial and error dari ketiga algoritma tersebut. Kemudian, memilih model regresi linier yang memiliki R-squared adjusted tertinggi dan nilai AIC paling kecil.

4.2.6 Adakah batasan nilai AIC yang dianggap kecil?

Nilai AIC memiliki interval dari -inf sampai +inf, sehingga tidak ada ketentuan yang menyatakan berapa nilai AIC yang dianggap kecil. Namun, untuk mengetahui apakah kombinasi model regresi linier yang dihasilkan sudah baik atau belum, user dapat melihat penurunan/peningkatan nilai AIC. Jika ketika melakukan stepwise regression baik dengan metode forward, backward, ataupun both nilai AIC sudah tidak mengalami penurunan, justru mengalami kenaikan ketika ditambah/dikurangkan prediktornya, maka iterasi sudah berhenti pada kombinasi model sebelum terjadi peningkatan nilai AIC.

4.3 Assumption

4.3.1 Mengapa pada asumsi normality yang harus berdistribusi normal adalah error/residual?

Nilai error/residual yang diharapkan untuk setiap analisis termasuk regrsi linier adalah 0, untuk memastikan bahwa hasil prediksi untuk setiap observasi mendekati atau sama dengan 0, maka diharapkan error/residual berdistribusi normal dimana nilai rata-rata error/residual sama dengan 0. Error/residual pada regresi linier seringkali tidak berdistribusi normal disebabkan oleh beberap faktor, yaitu:

- Model yang digunakan tidak cocok, misal hubungan antara prediktor dengan target variabel tidak linier melainkan kudratik/eksponensial/dll

- Terdapat observasi outlier

4.3.2 Mengapa perlu dilakukan pengecekkan asumsi model regresi linier?

Supaya interpretasi dan hasil prediksi dari model regresi linier bersifat BLUE (Best, Linear, Unbiased Estimator). Secara sederhana, hasil analisis regresi linier dapat berlaku secara objektif dan konsisten.

4.3.3 Jika sudah mencoba berbagai solusi untuk memperbaiki model regresi linier supaya asumsi terpenuhi, tetapi masih terdapat asumsi yang tidak terpenuhi apa yang harus dilakukan?

Hal tersebut berarti kondisi data historis yang tersedia tidak cocok dianalisis menggunakan model regresi linear. Anda dapat mencoba menganalisis data tersebut menggunakan metode/model lainnya seperti tree based method (regression tree) yang juga dapat dinterpretasikan dan free assumption.

4.3.4 Bagaiamna cara melakukan tes/uji normality terhadap error/residual jika jumlah sampel yang digunakan lebih dari 5000?

Anda dapat melakukan tes/uji normality terhadap error/residual menggunakan uji Kolmogorov Smirnov. Berikut contoh cara melakukan uji Kolmogorov Smirnov di R:

4.3.5 Bagaimana cara melakukan tes/uji korelasi antara prediktor dengan target variabel secara langsung untuk semua prediktor di R?

Fungsi yang digunakan untuk melakukan tes/uji korelasi di R adalah cor.test() sebagai berikut:

copiers <- read.csv("data/03-RM/copiers.csv") %>% select(-Row.ID)

cor.test(copiers$Sales, copiers$Profit)#>

#> Pearson's product-moment correlation

#>

#> data: copiers$Sales and copiers$Profit

#> t = 21.26, df = 60, p-value < 0.00000000000000022

#> alternative hypothesis: true correlation is not equal to 0

#> 95 percent confidence interval:

#> 0.9013320 0.9632858

#> sample estimates:

#> cor

#> 0.9395785Dengan hipotesis

- H0: Prediktor dan target tidak saling berkorelasi

- H1: Prediktor dan target saling berkorelasi

Anda dapat membuat suatu fungsi yang mengaplikasikan fungsi cor.test() di atas untuk setiap prediktor sebagai berikut:

cor.test.all <- function(data,target) {

names <- names(data %>% select_if(is.numeric))

df <- NULL

for (i in 1:length(names)) {

y <- target

x <- names[[i]]

p_value <- cor.test(data[,y], data[,x])[3]

temp <- data.frame(x = x,

y = y,

p_value = as.numeric(p_value))

df <- rbind(df,temp)

}

return(df)

}

cor.test.all(data = copiers, target ="Profit")#> x y p_value

#> 1 Sales Profit 0.00000000000000000000000000001271056

#> 2 Quantity Profit 0.00000000076036803959617475451651658

#> 3 Discount Profit 0.00044956416337473974241881191638015

#> 4 Profit Profit 0.000000000000000000000000000000000004.3.6 Apa akibat jika asumsi no-multicolinearity tidak terpenuhi?

Model regresi linier yang dihasilkan menjadi tidak efisien karena terdapat informasi yang redundan (sama). Ada baiknya model regresi linier yang dipilih adalah model regresi linier yang paling efisien dan sederhana dengan performa yang cukup baik (error yang dihasilkan relatif kecil)

4.4 Mathematics Formula

Untuk mengestimasi nilai koefisien (beta), pertama-tama coba ingat kembali beberapa konsep pada workshop “Practical Statistics”. Variance merupakan nilai yang menggambarkan seberapa bervariasi/beragamnya suatu variabel bertipe numerik/angka. Semakin besar nilai variance maka semakin beragam nilai dalam satu variabel (heterogen), sedangkan semakin kecil nilai variance maka semakin sama/mirip setiap observasi pada satu variabel (homogen). Data yang observasinya bernilai sama, maka variance sama dengan 0.

Sementara covariance merupakan nilai yang menggambarkan hubungan (positif/negatif/tidak ada hubungan) antara dua variabel numerik. Namun covariance tidak dapat menggambarkan seberapa erat/kuat hubungan tersebut karena nilai covariance tidak memilki batasan yang mutlak (- inf, + inf).

Dalam notasi matematika, anggap kita memiliki data yang terdiri dari 2 variabel, yaitu, , maka secara empiris nlai covariance diperoleh dari:

bisa juga diperoleh dari,

Jika formula dari covariance cukup rumit, coba ingat kembali formula dari variance:

pahami bahwa perbedaan variance dan covariance adalah variance hanya mengacu pada 1 variabel, sedangkan covariance mengacu pada 2 variabel. Maka, formula dari covariance:

Seperti yang telah dijelaskan di atas bahwa covariance menjelaskan jenis hubungan antara 2 variabel numerik. Namun, kita tidak dapat menilai seberapa erat/kuat hubungan antara keduanya karena interval nilai covariance yang tidak memiliki batasan. Oleh karena itu, kita bisa melakukan standarization terlebih dahulu terhadap 2 variabel numerik tersebut yang mengacu pada definisi correlation:

beberapa fakta mengenai correlation:

- Cor(X,Y) = Cor(Y,X)

- -1 <= Cor(X,Y) <= 1

- Nilai correlation mendekati 1 artinya kedua variabel berhubungan erat dan hubungannya linier positif

- Nilai correlation mendekati -1 artinya kedua variabel berhubungan erat dan hubungannya linier negatif

- Nilai correlation mendekati 0 artinya kedua variabel tidak saling berhubungan secara linier

Untuk menggambarkan persebaran observasi antara x dan y, dapat dilakukan dengan menarik suatu garis lurus yang menggambarkan keseluruhan persebaran data. Dimana, untuk menarik suatu garis lurus diperlukan titik awal () dan kemiringan garis ().

Lalu bagaimana cara mengestimasi dan yang optimal (dimana garis linier dapat menggambarkan keseluruhan persebaran data). Kita bisa menggunakan konsep kuadrat terkecil, untuk menemukan kombinasi dan yang meminimumkan jarak kuadrat antara titik pengamatan dengan garis linier:

- Estimasi slope:

- Estimasi intercept:

R-square secara definisi adalah persentase total keragaman suatu target variabel yang dapat dijelaskan oleh prediktor variabel (model), dengan formula:

Beberapa fakta tentang R-square ():

- adalah persentase total keragaman suatu target variabel yang dapat dijelaskan oleh model regresi

Namun, penggunaan R-square seringkali keliru karena adanya batasan dalam penggunaan metrik ini. R-square cenderung meningkat setiap penambahan variabel prediktor, walaupun variabel prediktor tersebut tidak mempengaruhi variabel target secara signifikan. Akibatnya, model dengan variabel prediktor yang lebih banyak mungkin tampak lebih baik hanya karena memiliki lebih banyak variabel prediktor saja.

Berbeda dengan Adjusted R-square yang tidak mengalami peningkatan setiap penambahan variabel prediktor karena adjusted R-square meningkat hanya ketika variabel prediktor baru benar-benar mengarah ke prediksi yang lebih baik (signifikan mempengaruhi variabel target).

Formula adjusted R-squared:

Dimana adalah jumlah pengamatan dan adalah jumlah prediktor. Perhatikan bahwa ketika meningkat, akan mengecil dan mendorong nilai adjusted R-square secara keseluruhan menjadi kecil.

Salah satu alat statistik yang dapat digunakan untuk mengecek ada/tidak multicolinearity adalah Variance Inflation Factor (VIF). VIF mengukur peningkatan estimasi koefisien beta, jika antar prediktor saling berkorelasi. Secara matematis, nilai VIF diperoleh dengan meregresikan setiap prediktor dengan prediktor lain. Contoh: diketahui terdapat , nilai VIF untuk diperoleh dari hasil regresi dengan , dst. Hasil regresi tersebut kemudian diterapkan pada formula berikut:

Secara umum jika nilai VIF yang diperoleh lebih besar atau sama dengan 10, mengindikasikan terjadi multicolinearity (antar prediktor saling berkorelasi kuat).

Bab 5 Classification 1

5.1 Classification in General

5.1.1 Pada kasus klasifikasi, penentuan kelas didasarkan pada peluang. Bagaimana jika peluang yang diperoleh sama besar, misalnya pada kasus klasifikasi biner diperoleh peluang masuk ke kelas positif adalah 0.5 dan peluang masuk ke kelas negatif juga 0.5?

Hal tersebut bergantung pada user yang menentukan threshold/batasan probability untuk masuk ke kelas positif atau masuk ke kelas negatif. Namun, pada umumnya jika diperoleh probability maka observasi tersebut akan masuk ke kelas positif.

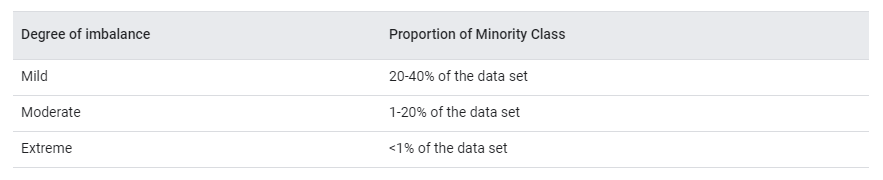

5.1.2 Permasalahan apa yang paling sering ditemui pada kasus klasifikasi?

Permasalahan yang sering ditemui pada kasus klasifikasi adalah proporsi target variabel yang tidak seimbang. Pada data di lapangan, nyatanya jumlah kelas positif jauh lebih sedikit dibandingkan kelas negatif. Contohnya:

- Perbankan: fraud detection, loan default

- Penerbangan: delay prediction

- Digital marketing: customer churn

- Kesehatan: cancer detection

- HR: employee attrition

- dan masih banyak lagi

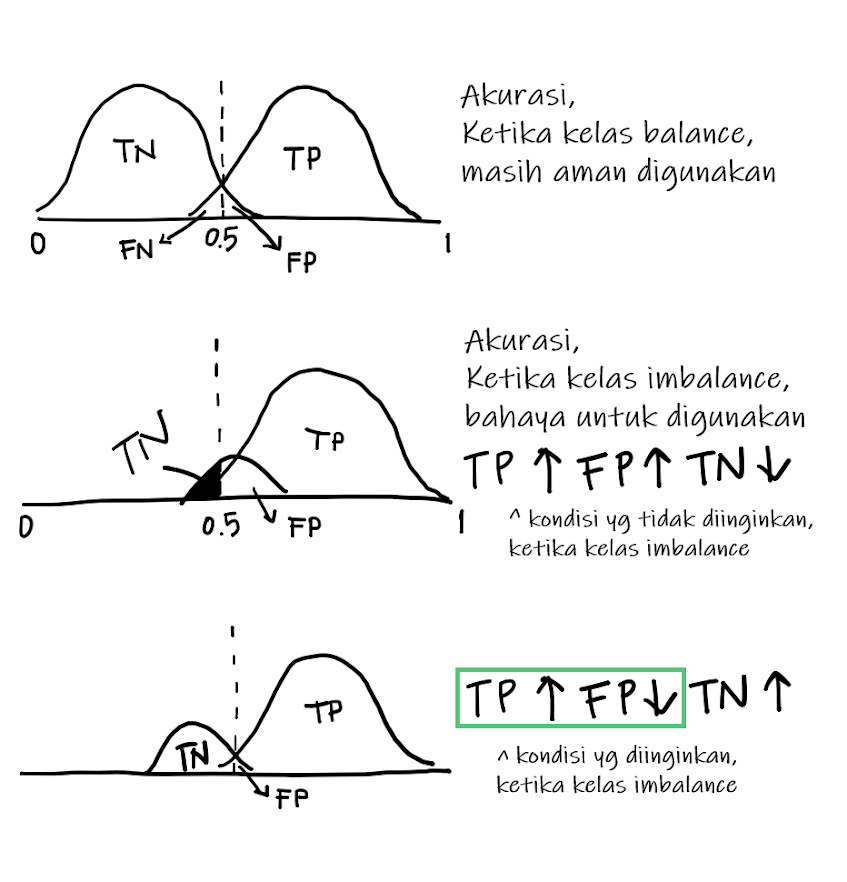

Misalkan pada kasus fraud detection, dari 1000 transaksi yang terjadi, hanya 10 diantaranya fraud. Hal tersebut akan berpengaruh terhadap kemampuan model untuk memprediksi target, karena model klasifikasi sangat bergantung pada jumlah setiap level target dalam proses learning-nya. Model klasifikasi cenderung lebih pintar dalam memprediksi kelas mayoritas. Hal ini menjadi masalah yang cukup serius, sehingga perlu dilakukan penanganan lebih lanjut.

attrition <- read_csv("data/04-C1/attrition.csv") %>%

mutate(attrition = as.factor(attrition))

prop.table(table(attrition$attrition)) %>% round(2)#>

#> no yes

#> 0.84 0.16Salah satu cara yang paling umum untuk menyeimbangkan proporsi target variabel adalah dengan metode sampling, yaitu downsampling dan upsampling.

Downsampling adalah proses sampling pada observasi kelas mayoritas sebanyak jumlah observasi pada kelas minoritas. Proses downsampling akan mengurangi jumlah observasi pada kelas mayoritas, sehingga memungkinkan terjadinya kehilangan informasi.

Upsampling adalah proses sampling pada observasi kelas minoritas sebanyak jumlah observasi pada kelas mayoritas. Proses upsampling akan menambah jumlah observasi pada kelas minoritas, sehingga hanya menduplikasi data yang terdapat pada kelas minoritas.

Berikut contoh downsampling dan upsampling dengan menggunakan fungsi pada library caret dan recipes:

Sebelum menerapkan downsampling dan upsampling terlebih dahulu dilakukan cross validation, yaitu membagi data menjadi training set untuk proses pemodelan dan testing set untuk melakukan evaluasi. Cross validation dilakukan dengan menggunakan fungsi initial_split() dari library rsample. Fungsi tersebut akan melakukan proses sampling dengan metode stratified random sampling, sehingga proporsi target variabel pada data awal dipertahankan dengan baik pada training set maupun testing set.

# define seed

set.seed(100)

# menentukan indeks untuk train dan test

splitted <- initial_split(data = attrition,

prop = 0.75,

strata = "attrition")

# mengambil indeks data train

train <- training(splitted)

# mengambil indeks data test`

test <- testing(splitted)#>

#> no yes

#> 0.84 0.16#>

#> no yes

#> 0.84 0.16Downsampling dan upsampling hanya dilakukan pada data train karena proses pembuatan model klasifikasi hanya dilakukan pada data train. Data test dianggap sebagai unseen data yang hanya digunakan untuk mengevaluasi model.

- Cara downsampling menggunakan

downSample()dari librarycaret

#>

#> no yes

#> 0.5 0.5- Cara upsampling menggunakan

upSample()dari librarycaret

#>

#> no yes

#> 0.5 0.5Berikut dokumentasi official dari library caret: downSample: Down- and Up-Sampling Imbalanced Data

- Cara downsampling/upsampling dengan

recipes

Seperti saat menggunakan fungsi pada library caret, ketika menggunakan fungsi dari library recipes juga harus dilakukan cross validation terlebih dahulu. Perbedaan ketika menggunakan fungsi dari library recipes adalah data train dan test tidak di-assign ke dalam sebuah objek melainkan dilakukan downsampling atau upsampling terlebih dahulu.

set.seed(417)

splitted_rec <- initial_split(data = attrition,

prop = 0.8,

strata = "attrition")

splitted_rec#> <Analysis/Assess/Total>

#> <1177/293/1470>Gunakan fungsi step_downsample() atau step_upsample() yang didefinisikan dalam sebuah recipe.

rec <- recipe(attrition ~ ., training(splitted)) %>%

# `step_downsample()` dapat diganti dengan `step_upsample()`

step_downsample(attrition, ratio = 1, seed = 100) %>%

prep()# membuat data train dengan fungsi `juice()`

train_rec <- juice(rec)

# membuat data test dengan fungsi `bake()`

test_rec <- bake(rec, testing(splitted))#>

#> no yes

#> 0.5 0.5Berikut dokumentasi official dari library recipes: tidymodels/recipes

5.2 Logistic Regression

5.2.1 Bagaimana model logistic regression menggunakan variabel kategorik sebagai prediktor?

Sama seperti kasus linear regression, pada logistic regression variabel kategorik harus diubah menjadi dummy variabel. Pada fungsi glm() sudah otomatis melakukan transformasi dummy variabel untuk kolom yang bertipe data character atau factor.

5.2.2 Bagaimana jika terdapat salah satu level pada prediktor kategorik yang tidak signifikan (p-value > alpha)? Apakah prediktor tersebut masih dianggap signifikan mempengaruhi target?

Level yang menjadi basis akan dianggap signifikan, sedangkan untuk level lainnya yang tidak signifikan artinya level tersebut tidak memberikan pengaruh terhadap target variabel. Solusi yang dapat dilakukan adalah:

- Binning, yaitu level tersebut digabungkan dengan level lainnya yang mirip dan signifikan

- Menambahkan jumlah observasi pada level yang tidak signifikan tersebut.

5.2.3 Pada fungsi lm() sudah otomatis melakukan transformasi data kategorik dengan level pertama yang dijadikan basis. Apakah pengubahan urutan level (reorder) akan mengubah hasil pemodelan?

Nilai p-value pada setiap level tidak akan berubah ketika kita melakukan reorder level. Interpretasi untuk variabel kategorik bergantung pada level yang dijadikan basis.

5.2.4 Apa pengertian dari Null Deviance dan Residual Deviance pada summary model?

- Null deviance menunjukkan seberapa baik model memprediksi target variabel hanya berdasarkan nilai intercept, tidak menggunakan predictor apapun.

- Residual deviance menunjukkan seberapa baik model memprediksi target variabel berdasarkan nilai intercept dan semua prediktor yang digunakan dalam model. Umumnya nilai Residual deviance lebih kecil dibandingkan null deviance.

Note: Null dan residual deviance hanya sebagian kecil tools yang bisa kita gunakan untuk mengevaluasi model mana yang paling baik. Namun perlu dijadikan catatan bahwa semakin banyak prediktor yang digunakan, nilai residual deviance pasti lebih kecil sehingga evaluasi menjadi bias. Pada praktiknya, confusion matrix lebih sering digunakan untuk melakukan evaluasi model klasifikasi.

Berikut link eksternal yang dapat dijadikan sebagai bahan referensi: Null deviance & Residual deviance

5.2.5 Apa itu Fisher Scoring pada summary model?

Fisher scoring adalah turunan dari metode Newton untuk mengatasi Maximum Likelihood. Fisher scoring memberikan informasi berapa banyak iterasi yang dilakukan pada model sehingga diperoleh nilai parameter pada summary.

5.2.6 Apa itu Maximum Likelihood Estimator (MLE)?

Nilai estimate pada model logistic regression diperoleh dengan pendekatan MLE. MLE merupakan pendekatan statistik untuk mendapatkan nilai estimate yang optimum pada model.

5.2.7 Apa yang dimaksud dari nilai Akaike Information Criterion (AIC)?